Никто из нас не ожидал, что именно так начнется 2025 год в сфере ИИ.

DeepSeek R1 поистине удивительно!

В последнее время "таинственная восточная сила" DeepSeek "жестко контролирует" Кремниевую долину.

Я попросил R1 подробно объяснить теорему Пифагора. Все это было сделано ИИ менее чем за 30 секунд без каких-либо ошибок. Короче говоря, все кончено.

В отечественных и зарубежных кругах ИИ обычные нетизены открыли для себя удивительный и мощный новый ИИ (который к тому же имеет открытый исходный код), а академические эксперты кричат "мы должны догнать". Также ходят слухи, что зарубежные ИИ-компании уже столкнулись с серьезной угрозой.

Взять хотя бы DeepSeek R1, выпущенный на этой неделе. Его чистый путь обучения с подкреплением без какого-либо контролируемого обучения просто шокирует. Начиная с разработки базы Deepseek-v3 в декабре прошлого года и заканчивая текущими возможностями мыслительной цепочки, сопоставимыми с OpenAI o1, кажется, что это вопрос времени.

Но пока сообщество ИИ занято чтением технических отчетов и сравнением реальных измерений, люди все еще сомневаются в R1: кроме того, что он способен превзойти кучу бенчмарков, может ли он действительно стать лидером?

Может ли он создавать собственные симуляции "физических законов"?

Вы не верите? Давайте дадим большой модели поиграть с пинболом?

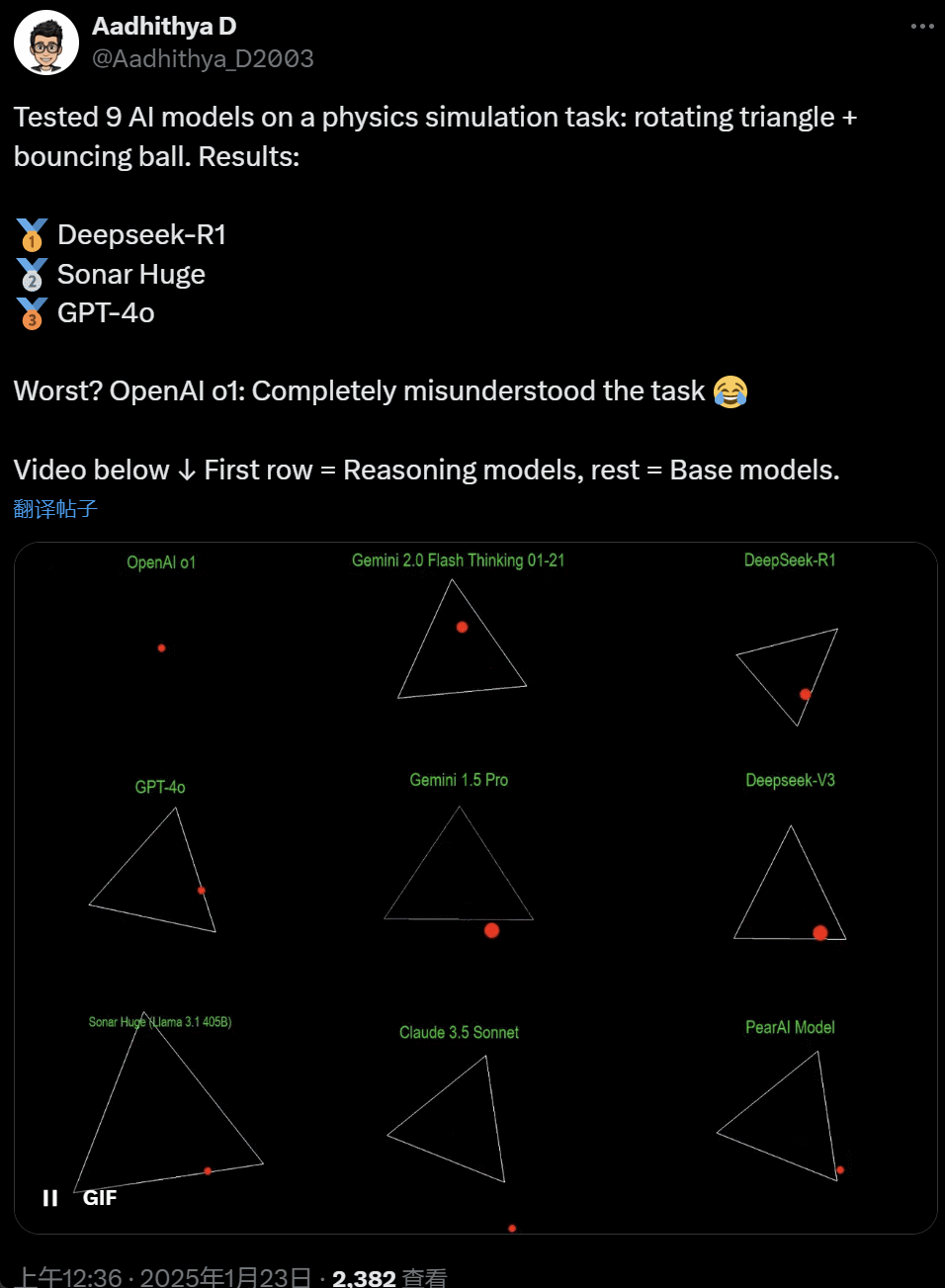

В последнее время некоторые люди в сообществе ИИ стали одержимы тестом - тестированием различных больших моделей ИИ (особенно так называемых рассуждающих моделей) для решения задачи: "Напишите скрипт на Python, который заставит желтый мяч подпрыгивать внутри определенной формы. Заставьте форму медленно вращаться и убедитесь, что мяч остается внутри формы".

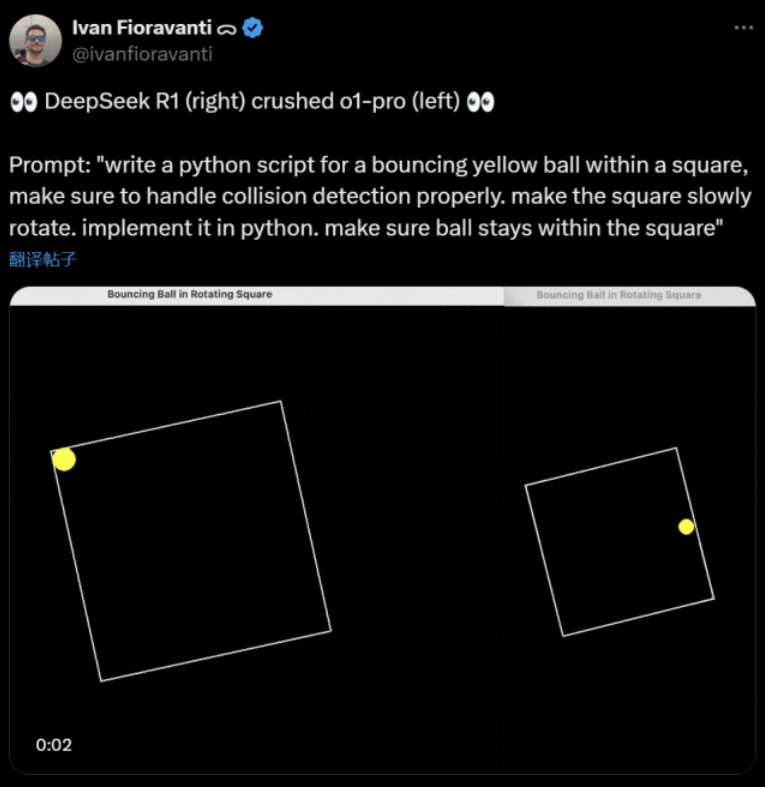

Некоторые модели превосходят другие в этом бенчмарке "вращающийся шар". По словам технического директора CoreView Ивана Фиораванти, DeepSeek, отечественная лаборатория искусственного интеллекта, имеет открытую большую модель R1, которая превосходит модель o1 pro от OpenAI, которая стоит $200 в месяц в рамках программы ChatGPT Pro от OpenAI.

Слева находится OpenAI o1, а справа - DeepSeek R1. Как уже говорилось выше, задание следующее: "напишите скрипт на python для прыгающего желтого шарика в квадрате, убедитесь, что он правильно обрабатывает обнаружение столкновений. сделайте квадрат медленно вращающимся. реализуйте это на python. убедитесь, что шарик остается в пределах квадрата".

По словам другого пользователя X, модели Anthropic Claude 3.5 Sonnet и Google Gemini 1.5 Pro давали неверные суждения о физических принципах, в результате чего мяч отклонялся от своей формы. Некоторые пользователи также сообщили, что новейшая модель Gemini 2.0 Flash Thinking Experimental от Google, а также относительно старая модель OpenAI GPT-4o сразу же прошли оценку.

Но здесь есть способ увидеть разницу:

Нетизены под этим твитом заявили: способности o1 изначально были очень хорошими, но после того, как OpenAI оптимизировал скорость, они стали слабее, даже с версией членства $200/месяц.

Моделирование прыгающего мяча - классическая задача программирования. Точное моделирование сочетает в себе алгоритмы обнаружения столкновений, которые должны определить, когда два объекта (например, мяч и боковая сторона фигуры) сталкиваются. Неправильно написанный алгоритм может повлиять на производительность симуляции или привести к очевидным физическим ошибкам.

N8 Programs, исследователь из ИИ-стартапа Nous Research, говорит, что ему потребовалось около двух часов, чтобы с нуля написать прыгающий мяч во вращающемся семиугольнике. "Необходимо отслеживать несколько систем координат, понимать, как обрабатываются столкновения в каждой системе, и разрабатывать код с нуля, чтобы он был надежным".

Хотя прыгающие мячи и вращающиеся фигуры - это разумная проверка навыков программирования, это все еще новые проекты для больших моделей, и даже небольшие изменения в подсказках могут привести к разным результатам. Поэтому, если мы хотим, чтобы этот проект стал частью эталонного теста для больших моделей ИИ, его еще нужно усовершенствовать.

В любом случае, после этой волны практических тестов мы получили представление о различиях в возможностях больших моделей.

DeepSeek - новый "миф Кремниевой долины

DeepSeek вызывает панику" по всему Тихому океану.

Сотрудники Meta написали, что "инженеры Meta неистово анализируют DeepSeek, пытаясь скопировать с него все, что можно".

Александр Ванг, основатель технологического ИИ-стартапа Scale AI, также публично заявил, что производительность большой ИИ-модели DeepSeek примерно эквивалентна лучшей модели в США.

Он также считает, что Соединенные Штаты, возможно, опережали Китай в соревновании по ИИ в течение последнего десятилетия, но выпуск компанией DeepSeek своей большой модели ИИ может "изменить все".

X-блогер @8teAPi считает, что DeepSeek - это не "побочный проект", а что-то вроде бывшего "Skunk Works" компании Lockheed Martin.

Так называемый "Skunk Works" - это строго конфиденциальная, относительно независимая небольшая команда, которую компания Lockheed Martin изначально создала для разработки многих современных самолетов, занимаясь исследованиями и разработкой передовых или нетрадиционных технологий. От самолета-разведчика U-2 и SR-71 Blackbird до F-22 Raptor и истребителя F-35 Lightning II - все они вышли отсюда.

Позже этот термин постепенно превратился в общий термин, используемый для описания "маленьких, но прекрасных", относительно независимых и более гибких инновационных команд, созданных в крупных компаниях или организациях.

Он назвал две причины:

- С одной стороны, DeepSeek имеет большое количество графических процессоров, по некоторым данным, более 10 000, а Александр Ванг, генеральный директор Scale AI, даже заявил, что их количество может достигать 50 000.

- С другой стороны, DeepSeek набирает таланты только из трех лучших университетов Китая, что означает, что DeepSeek так же конкурентоспособна, как Alibaba и Tencent.

Эти два факта свидетельствуют о том, что DeepSeek явно добилась коммерческого успеха и достаточно известна, чтобы получить эти ресурсы.

Что касается стоимости разработки DeepSeek, блогер отметил, что китайские технологические компании могут получать различные субсидии, например, низкие затраты на электроэнергию и использование земли.

Поэтому вполне вероятно, что большая часть затрат DeepSeek была "размещена" на счете, не относящемся к основному бизнесу, или в виде субсидий на строительство дата-центров.

Даже кроме основателей, никто до конца не понимает всех финансовых договоренностей. Некоторые соглашения могут быть просто "устными", которые заключаются только на основе репутации.

Как бы то ни было, несколько вещей очевидны:

- Модель отличная, сравнимая с версией, выпущенной OpenAI два месяца назад, и, конечно, возможно, что она не так хороша, как новые модели, которые OpenAI и Anthropic еще не выпустили.

- С нынешней точки зрения, в направлении исследований по-прежнему доминируют американские компании. Модель DeepSeek является "быстрым продолжением" версии o1, но прогресс в исследованиях и разработках DeepSeek очень быстрый, и он опережает ожидания. Они не занимаются плагиатом или мошенничеством, в лучшем случае они занимаются реверс-инжинирингом.

- DeepSeek в основном готовит собственные кадры, а не полагается на американских докторов наук, что значительно расширяет кадровый резерв.

- По сравнению с американскими компаниями, DeepSeek подвержена меньшим ограничениям с точки зрения лицензирования интеллектуальной собственности, конфиденциальности, безопасности, политики и т. д., и у нее меньше опасений по поводу неправомерного использования данных, которые люди не хотят, чтобы их обучали. Меньше судебных исков, меньше юристов и меньше проблем.

Несомненно, все больше людей верят в то, что 2025 год станет решающим. Тем временем компании готовятся к нему. Например, компания Meta строит центр обработки данных мощностью 2 ГВт+, инвестиции в который к 2025 году составят $60-65 миллиардов, а к концу года в нем будет более 1,3 миллиона графических процессоров.

Meta даже использовала график для сравнения своего 2-гигаваттного центра обработки данных с Манхэттеном, Нью-Йорк.

Но теперь DeepSeek стала лучше за счет более низкой стоимости и меньшего количества GPU. Как это может не вызывать беспокойства?

Янн ЛеКун: Мы должны поблагодарить технического директора и соучредителя компании сайт открытый исходный код

Hyperbolic, Yuchen Jin, за публикацию, что всего за 4 дня DeepSeek-R1 доказал нам 4 факта:

- ИИ с открытым исходным кодом отстает от ИИ с закрытым исходным кодом всего на 6 месяцев

- Китай доминирует в конкурсе ИИ с открытым исходным кодом

- Мы вступаем в золотой век обучения с подкреплением на основе больших языковых моделей

- Дистилляционные модели очень мощные, и мы будем запускать высокоинтеллектуальный ИИ на мобильных телефонах

Цепная реакция, вызванная DeepSeek, все еще продолжается: OpenAI o3-mini стал свободно доступен, в сообществе появилась надежда на уменьшение неясных дискуссий об AGI/ASI, а также слухи о том, что Мета находится в панике.

Он считает, что трудно предсказать, кто в итоге победит, но не стоит забывать о силе преимущества опоздавших. В конце концов, все мы знаем, что именно Google изобрела трансформер, а OpenAI раскрыла его истинный потенциал.

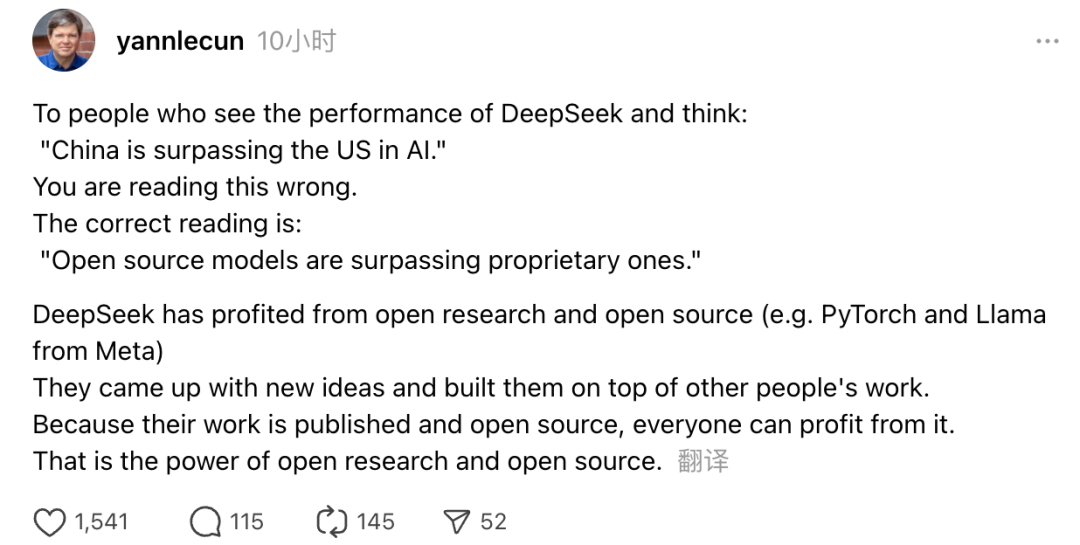

Кроме того, свое мнение высказал лауреат премии Тьюринга и главный научный сотрудник Meta по искусственному интеллекту Ян ЛеКун.

"Те, кто, увидев результаты работы DeepSeek, подумают: "Китай обгоняет США в области ИИ", - ошибаются. Правильное понимание заключается в том, что модели с открытым исходным кодом обгоняют проприетарные модели".

По словам ЛеКуна, причина, по которой DeepSeek добилась такого успеха в этот раз, заключается в том, что им помогли открытые исследования и открытый исходный код (например, PyTorch и Llama от Meta). DeepSeek предложила новые идеи и использовала наработки других. Поскольку их работа публично опубликована и имеет открытый исходный код, все могут извлечь из нее пользу. В этом и заключается сила открытых исследований и открытого исходного кода.

Размышления нетизенов продолжаются. В то время как они радуются развитию новых технологий, они также чувствуют некоторую атмосферу тревоги. Ведь появление DeepSeekers может иметь реальные последствия.