o3-mini kom sent på kvällen, och OpenAI avslöjade äntligen sitt senaste trumfkort. Under en Reddit AMA Q&A erkände Altman djupt att han hade stått på fel sida av open source AI.

Han sade att den interna strategin för öppen källkod övervägs och att modellen kommer att fortsätta att utvecklas, men OpenAI:s försprång kommer inte att vara lika stort som tidigare.

Medan alla fortfarande förundrades över den fantastiska kraften hos DeepSeek kunde OpenAI till slut inte sitta still längre.

Tidigt på morgonen i går lanserades o3-mini, som satte nya SOTA i riktmärkestester som matematisk kod och återvände till tronen.

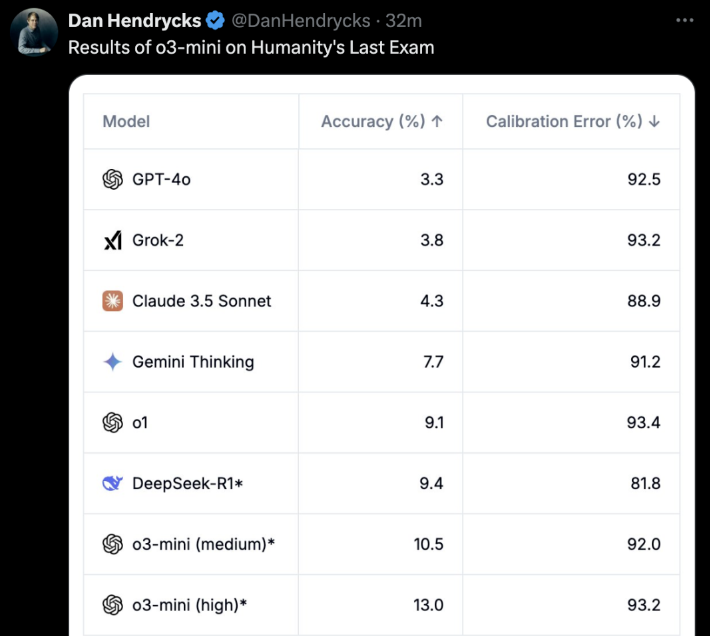

Det viktigaste är att gratisanvändare kan uppleva det också! o3-mini är inget skämt. I det "sista provet för människor" uppnådde o3-mini (hög) direkt den bästa noggrannheten och kalibreringsfelet.

Några timmar efter o3-mini gick onlineöppnade OpenAI officiellt en Reddit AMA i ungefär en timme.

Altman själv gick också ut på nätet och svarade på alla frågor från nätanvändarna.

De viktigaste höjdpunkterna är:

- DeepSeek är verkligen mycket braoch vi kommer att fortsätta att utveckla bättre modeller, men försprånget kommer inte att vara lika stort som tidigare

- Jämfört med för några år sedan är jag nu mer benägen att tro att AI kan komma att ta snabba språng

- Vi är på fel sida i frågan om open-sourcing av viktade AI-modeller

- En uppdatering av det avancerade röstläget kommer snart, och vi kommer att kalla det GPT-5 direkt, inte GPT-5o. Det finns ingen specifik tidtabell ännu.

Förutom Altman själv var Chief Research Officer Mark Chen, Chief Product Officer Kevin Weil, Vice President of Engineering Srinivas Narayanan, Head of API Research Michelle Pokrass och Head of Research Hongyu Ren också online och svarade noggrant på alla frågor från netizens.

Låt oss sedan ta en titt på vad de alla sa.

Altman ångrar djupt att han valde fel sida i AI-striden med öppen källkod

DeepSeek:s plötsliga comeback kan ha varit oväntad för alla.

Under AMA:s frågestund ångrade Altman också djupt att han valt fel sida i AI-striden med öppen källkod och tvingades erkänna DeepSeek:s starka fördelar.

Det som förvånade många var att Altman till och med sa att OpenAI:s ledning inte var lika stark som den brukade vara.

Här följer alla de klassiska svar vi har sammanställt från Altman.

Q: Låt oss prata om veckans stora ämne: Deepseek. Det är helt klart en mycket imponerande modell, och jag vet att den förmodligen tränades ovanpå utdata från andra LLM: er. Hur kommer detta att förändra dina planer för framtida modeller?

Altman: Det är verkligen en mycket imponerande modell! Vi kommer att utveckla bättre modeller, men vi kommer inte att kunna behålla en lika stor ledning som tidigare år.

F: Tror du att rekursiv självförbättring kommer att vara en gradvis process eller en plötslig start?

Altman: Personligen tror jag att jag är mer benägen att tro att AI kan göra snabba framsteg än vad jag var för några år sedan. Kanske är det dags att skriva något om det här ämnet...

F: Kan vi se alla tokens som modellen tänker på?

Altman: Ja, vi kommer snart att visa en mer användbar och detaljerad version. Tack till R1 för uppdateringen.

Kevin Weil, Chief Product Officer: Vi arbetar på att visa mer än vad vi gör nu - det kommer att ske snart. Huruvida vi visar allt eller inte återstår att avgöra. Att visa alla tankekedjor (CoT) skulle leda till destillering av konkurrentmodeller, men vi vet också att användare (åtminstone avancerade användare) vill se detta, så vi kommer att hitta en bra balans.

Q: När kommer den fullständiga versionen av o3 att vara tillgänglig?

Altman: Jag skulle uppskatta att det blir mer än några veckor, men inte mer än några månader.

Q: Kommer det att finnas en uppdatering av röstläget? Är detta potentiellt ett fokus för GPT-5o? Vad är den ungefärliga tidslinjen för GPT-5o?

Altman: Ja, en uppdatering av det avancerade röstläget är på väg! Jag tror att vi bara kommer att kalla det GPT-5, inte GPT-5o. Det finns ingen specifik tidslinje ännu.

Q: Skulle du kunna tänka dig att släppa några modellvikter och publicera lite forskning?

Altman: Ja, vi diskuterar det. Jag tycker personligen att vi är på fel sida i den här frågan och behöver komma fram till en annan strategi för öppen källkod; inte alla på OpenAI delar denna åsikt, och det är inte vår högsta prioritet just nu.

Ytterligare en fråga:

- Hur nära är vi att kunna erbjuda Operator i det ordinarie Plus-programmet?

- Vilka är robotavdelningens främsta prioriteringar?

- Vad tycker OpenAI om mer specialiserade chips/TPU:er, som Trillium, Cerebras, etc.? Är OpenAI uppmärksam på detta?

- Vilka investeringar görs för att säkra mot framtida risker i AGI och ASI?

- Vilken var din mest minnesvärda semester?

Altman:

- Några månader

- att producera en riktigt bra robot i liten skala och lära sig av erfarenheterna

- GB200 är för närvarande svår att slå!

- Ett bra val skulle kunna vara att förbättra ditt inre tillstånd - motståndskraft, anpassningsförmåga, lugn, glädje etc.

- Det är svårt att välja! Men de två första som jag kommer att tänka på är: backpacking i Sydostasien eller safari i Afrika

Q: Planerar ni att höja priset på Plus-serien?

Altman: Egentligen vill jag gradvis minska den.

Fråga: Anta att det nu är år 2030 och att du just har skapat ett system som de flesta skulle kalla en AGI. Det utmärker sig i alla benchmarktester och överträffar dina bästa ingenjörer och forskare när det gäller hastighet och prestanda. Vad händer nu? Förutom att "lägga upp det på hemsidan och erbjuda det som en tjänst", har du några andra planer?

Altman: Den viktigaste effekten, enligt min mening, kommer att vara att påskynda vetenskapliga upptäckter, vilket jag tror är den faktor som kommer att bidra mest till att förbättra livskvaliteten.

4o bildgenerering, kommer snart

Därefter lades svar från andra OpenAI-medlemmar till.

Q: Planerar ni fortfarande att lansera bildgeneratorn 4o?

Kevin Weil, Chief Product Officer: Ja! Och jag tycker att det är värt att vänta.

Fråga: Toppen! Finns det en ungefärlig tidtabell?

Kevin Weil, produktchef: Du ber mig att hamna i trubbel. Kanske några månader.

Och en annan liknande fråga.

Fråga: När kan vi förvänta oss att se ChatGPT-5?

Kevin Weil, Chief Product Officer: Strax efter o-17 micro och GPT-(π+1).

Och en annan fråga dyker upp:

- Vilka andra typer av agenter kan vi förvänta oss?

- Och även tillhandahålla en agent för gratisanvändare, vilket kan påskynda antagandet ...

- Några uppdateringar om den nya versionen av DALL-E?

- En sista fråga, och det är den som alla ställer... När kommer AGI att implementeras?

Kevin Weil, Chief Product Officer:

- Fler agenter: mycket, mycket snart. Jag tror att du kommer att bli glad.

- Bildgenerering baserad på 4o: om några månader, jag kan inte vänta på att du ska använda den. Den är fantastisk.

- AGI: Ja

Q: Planerar ni att lägga till funktionalitet för filbilagor i resonemangsmodellen?

Srinivas Narayanan, teknisk chef: Det är under utveckling. I framtiden kommer resonemangsmodellen att kunna använda olika verktyg, inklusive sökfunktioner.

Kevin Weil, produktchef: Bara för att säga, jag kan inte vänta med att se resonemangsmodellen för att kunna använda verktyg

F: Verkligen. När du löser det här problemet öppnas några mycket användbara AI-applikationsscenarier upp. Föreställ dig att AI kan förstå innehållet i dina 500 GB arbetsdokument.

När du ska svara på ett e-postmeddelande öppnas en panel bredvid din e-postapp som kontinuerligt analyserar all information som är relaterad till den här personen, inklusive er relation, de ämnen som diskuterats, tidigare arbete osv. Kanske kommer något från ett dokument som du länge har glömt att flaggas eftersom det är mycket relevant för den aktuella diskussionen. Jag vill så gärna ha den här funktionen.

Srinivas Narayanan, teknisk chef: Vi arbetar på att öka längden på sammanhanget. Det finns inget fast datum/tillkännagivande ännu.

Fråga: Hur viktigt är Stargate-projektet för OpenAI:s framtid? Kevin Weil, produktchef: Mycket viktigt. Allt vi har sett tyder på att ju mer beräkningskraft vi har, desto bättre modeller kan vi bygga och desto mer värdefulla produkter kan vi skapa.

Vi skalar modeller i två dimensioner just nu - större förträning och mer förstärkningsinlärning (RL) / "jordgubbs" -träning - som båda kräver beräkningsresurser.

Att betjäna hundratals miljoner användare kräver också beräkningsresurser! Och när vi går mot mer intelligenta agentprodukter som kan arbeta för dig kontinuerligt, kräver detta också beräkningsresurser. Så du kan tänka på Stargate som vår fabrik, där elektricitet/GPU:er omvandlas till fantastiska produkter.

Fråga: Internt, vilken modell använder du nu? o4, o5 eller o6? Hur mycket smartare är dessa interna modeller jämfört med o3?

Michelle Pokrass, chef för API Research: Vi har tappat räkningen.

Q: Snälla, låt oss interagera med text/canvas samtidigt som vi använder avancerade röstfunktioner. Jag vill kunna tala till den och få den att iterativt modifiera dokument.

Kevin Weil, Chief Product Officer: Ja! Vi har många bra verktyg som har utvecklats relativt självständigt - målet är att få ut dessa verktyg i dina händer så snabbt som möjligt.

Nästa steg är att integrera alla dessa funktioner så att du kan prata med en modell, som söker och resonerar samtidigt, och generera en canvas som kan köra Python. Alla verktyg måste fungera bättre tillsammans. Och förresten, alla modeller behöver full verktygsåtkomst (modellerna i o-serien kan för närvarande inte använda alla verktyg), vilket också kommer att implementeras.

Q: När kommer modellerna i o-serien att stödja minnesfunktionen i ChatGPT?

Michelle Pokrass, chef för API Research: Det är under utveckling! Att förena alla våra funktioner med modellerna i o-serien är vår högsta prioritet.

Fråga: Kommer det att ske några större förbättringar av 4o? Jag gillar verkligen den anpassade GPT:n, och det skulle vara bra om den kunde uppgraderas, eller om vi kunde välja vilken modell som ska användas i den anpassade GPT:n (t.ex. o3 mini).

Michelle Pokrass, chef för API Research: Ja, vi är inte klara med 4o-serien än!