El alto costo de usar modelos de IA de gran tamaño es una de las principales razones por las que muchas aplicaciones de IA aún no se han implementado ni promovido. Elegir un rendimiento extremo implica enormes costos de potencia de procesamiento, lo que genera altos costos de uso que los usuarios comunes no pueden aceptar.

La competencia por los modelos de IA de gran tamaño es como una guerra sin humo. Después de que DeepSeek lanzara y abriera el código fuente del último modelo de gran tamaño R1, OpenAI también lanzó su propio modelo o3 más reciente bajo presión. El gran jugador de modelos Google también tuvo que sumarse a la feroz competencia por los modelos de bajo costo.

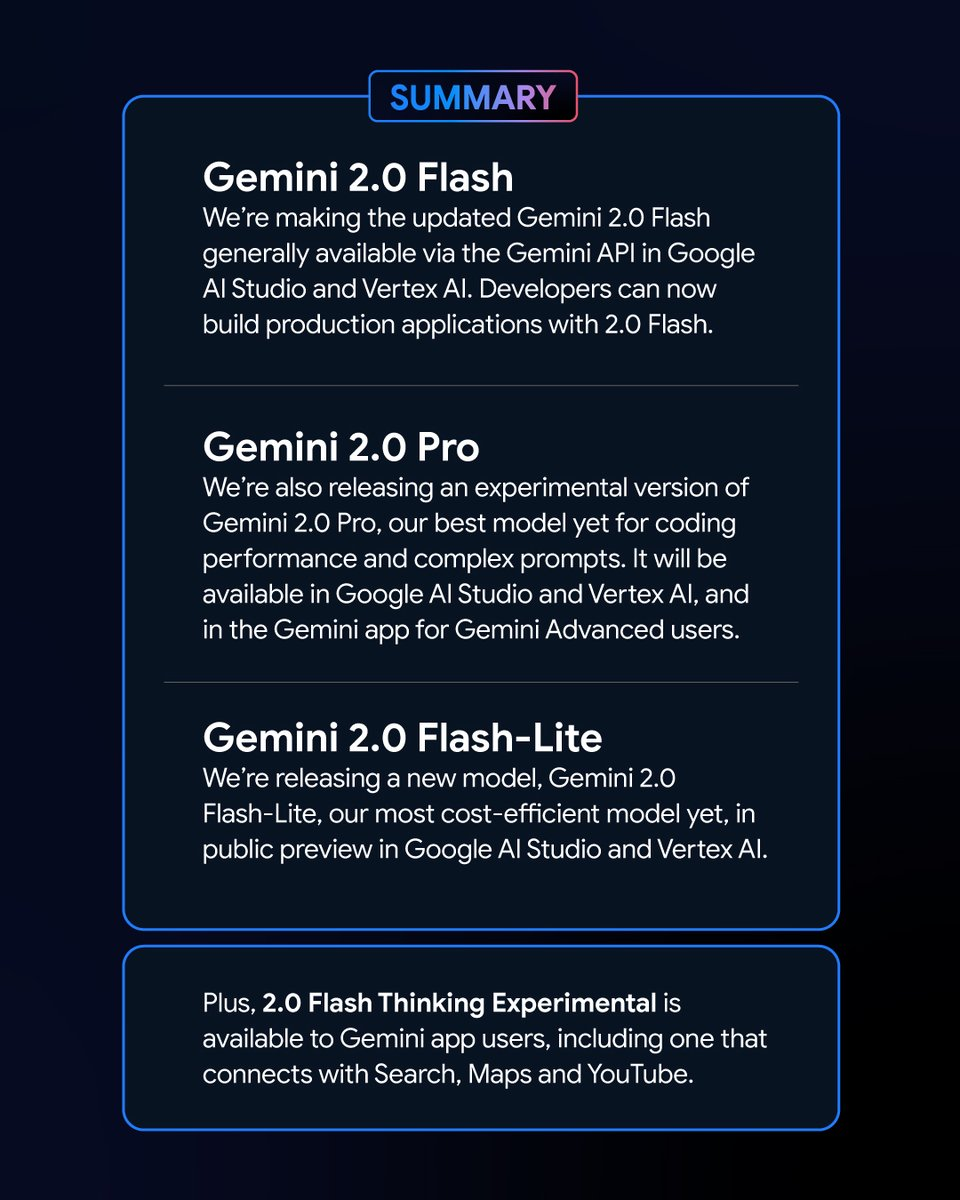

El nuevo movimiento de Google: se revelan los nuevos miembros de la serie Gemini

En la madrugada del 6 de febrero, Google lanzó una serie de nuevas versiones del modelo Gemini. Entre ellas, la versión experimental de Géminis 2.0 La versión Pro y la versión preliminar de Gemini 2.0 Flash – Lite atrajeron mucha atención, y la última versión de Gemini 2.0 Flash fue lanzada oficialmente.

Como nueva variante, Google Géminis 2.0 Flash – Lite tiene un precio muy atractivo de solo 0,3 USD por millón de tokens, lo que lo convierte en el modelo más asequible de Google hasta la fecha.

La versión experimental de Gemini 2.0 Pro, por otro lado, tiene potentes capacidades multimodales nativas que pueden convertir entre texto, audio y video.

La versión experimental de Gemini 2.0 Flash Thinking es de uso gratuito y también tiene la capacidad de acceder, extraer y resumir el contenido de los vídeos de YouTube.

Logan Kilpatrick, jefe de productos de Google AI Studio, anunció en la plataforma X que estos modelos son “los modelos más poderosos en la historia de Google” y están disponibles para todos los desarrolladores.

El impresionante rendimiento y los resultados de los nuevos modelos Gemini en la clasificación

En la clasificación de modelos grandes de Chatbot Arena, Gemini 2.0 Flash Thinking Experimental Edition y Gemini 2.0 Pro Experimental Edition han logrado resultados sobresalientes. En comparación con los modelos grandes anteriores de Google, Gemini 2.0 ha logrado un gran progreso y, como era de esperar, ha alcanzado con éxito la cima de la clasificación, con una puntuación combinada que supera a ChatGPT-4o y DeepSeek-R1. Esto es una gran mejora.

Este resultado se basa en una evaluación exhaustiva de las capacidades de los modelos grandes en diversas áreas, incluidas las matemáticas, la codificación y el procesamiento multilingüe.

Precio y rendimiento: cada variante de Gemini 2.0 tiene sus propias ventajas

Las distintas versiones de Gemini 2.0 tienen sus propias características en cuanto a precio y rendimiento. Se ha conseguido un equilibrio entre rendimiento y precio, ofreciendo a los usuarios más opciones. Las API de las distintas versiones de Gemini 2.0 se pueden llamar a través de Google AI Studio y Vertex AI. Los desarrolladores y usuarios pueden elegir la versión adecuada según sus necesidades.

Gemini 2.0 ha logrado un gran progreso y desarrollo en comparación con Gemini 1.5. Aunque las diferentes versiones de Gemini 2.0 tienen diferencias, todas han mejorado en general. En concreto, debes determinar el escenario que estás utilizando y, luego, podrás elegir mejor el modelo de Gemini que más te convenga.

En términos de precio, Gemini 2.0 Flash y Gemini 2.0 Flash – Lite se centran en una implementación liviana. Admiten hasta 1 millón de tokens en la longitud de la ventana de contexto y, en términos de precio, se ha eliminado la distinción entre procesamiento de texto largo y corto en Gemini 1.5 Flash y el precio se unificó en un precio de token unitario.

Gemini 2.0 Flash cuesta 0,4 USD por millón de tokens para la salida de texto, que es la mitad del precio de Gemini 1.5 Flash cuando se procesan textos largos.

Gemini 2.0 Flash – Lite es incluso mejor en la optimización de costos en escenarios de salida de texto a gran escala, con un precio de salida de texto de 0,3 USD por millón de tokens. Incluso el CEO de Google, Sundar Pichai, lo elogió como "eficiente y poderoso".

En términos de mejora del rendimiento, Gemini 2.0 Flash tiene funciones de interacción multimodal más completas que la versión Lite. Está previsto que admita salida de imágenes, así como entrada y salida bidireccional en tiempo real de baja latencia de modalidades como texto, audio y vídeo.

La versión experimental de Gemini 2.0 Pro destaca en cuanto a rendimiento de codificación y mensajes complejos. Su ventana de contexto puede alcanzar hasta 2 millones de tokens, y su capacidad general ha aumentado de 75,8% a 79,1% en comparación con la generación anterior, lo que supone una diferencia significativa en la capacidad de codificación y razonamiento con Gemini 2.0 Flash y Gemini 2.0 Flash – Lite.

El equipo de la aplicación Gemini dijo en la plataforma X que los usuarios de Gemini Advanced pueden acceder a la versión experimental de Gemini 2.0 Pro a través del menú desplegable del modelo, y la versión experimental de Gemini 2.0 Flash Thinking es gratuita para los usuarios de la aplicación Gemini, y esta versión se puede usar junto con YouTube, la búsqueda de Google y Google Maps.

Contrarrestar la competencia: concurso de rentabilidad del modelo Google

En un momento en que el costo del desarrollo de modelos se ha convertido en un tema candente en la industria, el lanzamiento del DeepSeek – R1 de código abierto, de bajo costo y alto rendimiento ha tenido un impacto en toda la industria.

Durante la conferencia telefónica posterior a la publicación del informe financiero del cuarto trimestre de 2024 de Google, Pichai, si bien reconoció los logros de DeepSeek, también enfatizó que la serie de modelos Gemini es líder en el equilibrio entre costo, rendimiento y latencia, y que su rendimiento general es mejor que el de los modelos V3 y R1 de DeepSeek.

Desde la perspectiva de la clasificación de la prueba comparativa de rendimiento de modelos grandes LiveBench creada por Yang Likun y su equipo, la clasificación general de Gemini 2.0 Flash es más alta que la de DeepSeek V3 y o1-mini de OpenAI, pero está detrás de DeepSeek-R1 y o1 de OpenAI. Sin embargo, el lanzamiento de Gemini 2.0 Flash-Lite por parte de Google es como una carta de triunfo. Google espera hacer que los últimos modelos grandes sean asequibles para más personas, reducir los costos de uso de los usuarios y espera ocupar un lugar en la competencia entre empresas por precio/rendimiento.

Después de que Google lanzó el El último Gemini 2.0Un internauta comenzó a intentar analizar Gemini 2.0 Flash y otros modelos populares deepseek y openai GPT-4o por su cuenta. Descubrió que la nueva versión de Gemini 2.0 Flash supera a los otros dos modelos tanto en términos de rendimiento como de costo. Esto también nos da una idea del desarrollo y la evolución de Google, y es un buen comienzo.

En concreto, Gemini 2.0 Flash cuesta 0,1 USD por millón de tokens para la entrada y 0,4 USD para la salida, ambos precios muy inferiores a los de DeepSeek V3. Se trata de una gran mejora y desarrollo. El internauta también señaló en la plataforma X: "La versión oficial de Gemini 2.0 Flash cuesta un tercio de GPT-4o-mini, mientras que es tres veces más rápida".

Una nueva tendencia en el mercado de los modelos grandes: la relación calidad-precio es la clave

Hoy en día, el campo de los modelos grandes se encuentra atrapado en una nueva guerra de precios. En el pasado, el alto costo de usar modelos grandes ha creado cierta resistencia a su uso y promoción. El impacto de la guerra de precios de los modelos grandes desencadenada por DeepSeek en el mercado de modelos grandes en el extranjero aún continúa fermentando. Al mismo tiempo, la opción de código abierto también ha permitido que más usuarios comprendan y utilicen los últimos resultados de la investigación de modelos grandes. La estrategia de código abierto + precio bajo también ha ejercido presión sobre muchas empresas estadounidenses de modelos grandes.

Google lanzó Gemini 2.0 Flash-Lite y OpenAI puso a disposición de todos los usuarios la función de búsqueda ChatGPT de forma gratuita, de modo que los usuarios puedan utilizarla para realizar tareas más diversas. El equipo interno de Meta también está intensificando la investigación sobre estrategias de reducción de precios de modelos grandes y, al mismo tiempo, está promoviendo el desarrollo de los modelos grandes de código abierto de Meta.

En este campo altamente competitivo, ninguna empresa puede estar cómoda en el primer puesto. Las empresas están tratando de atraer y retener a los usuarios mejorando la relación coste-eficacia. Esta tendencia ayudará a que los modelos de gran tamaño pasen del desarrollo puramente tecnológico a una aplicación más amplia, y el futuro mercado de modelos de gran tamaño seguirá evolucionando y cambiando en la competencia por la relación coste-eficacia.