Le coût élevé de l'utilisation de grands modèles d'IA est l'une des principales raisons pour lesquelles de nombreuses applications d'IA n'ont pas encore été mises en œuvre et promues. Le choix de performances extrêmes implique des coûts de puissance de calcul énormes, ce qui entraîne des coûts d'utilisation élevés que les utilisateurs ordinaires ne peuvent pas accepter.

La concurrence pour les grands modèles d'IA est comme une guerre sans fumée. Après que DeepSeek a publié et ouvert le code source du dernier grand modèle R1, OpenAI a également publié son propre dernier modèle o3 sous pression. Le grand acteur des modèles Google a également dû se joindre à la concurrence féroce pour les modèles à bas prix.

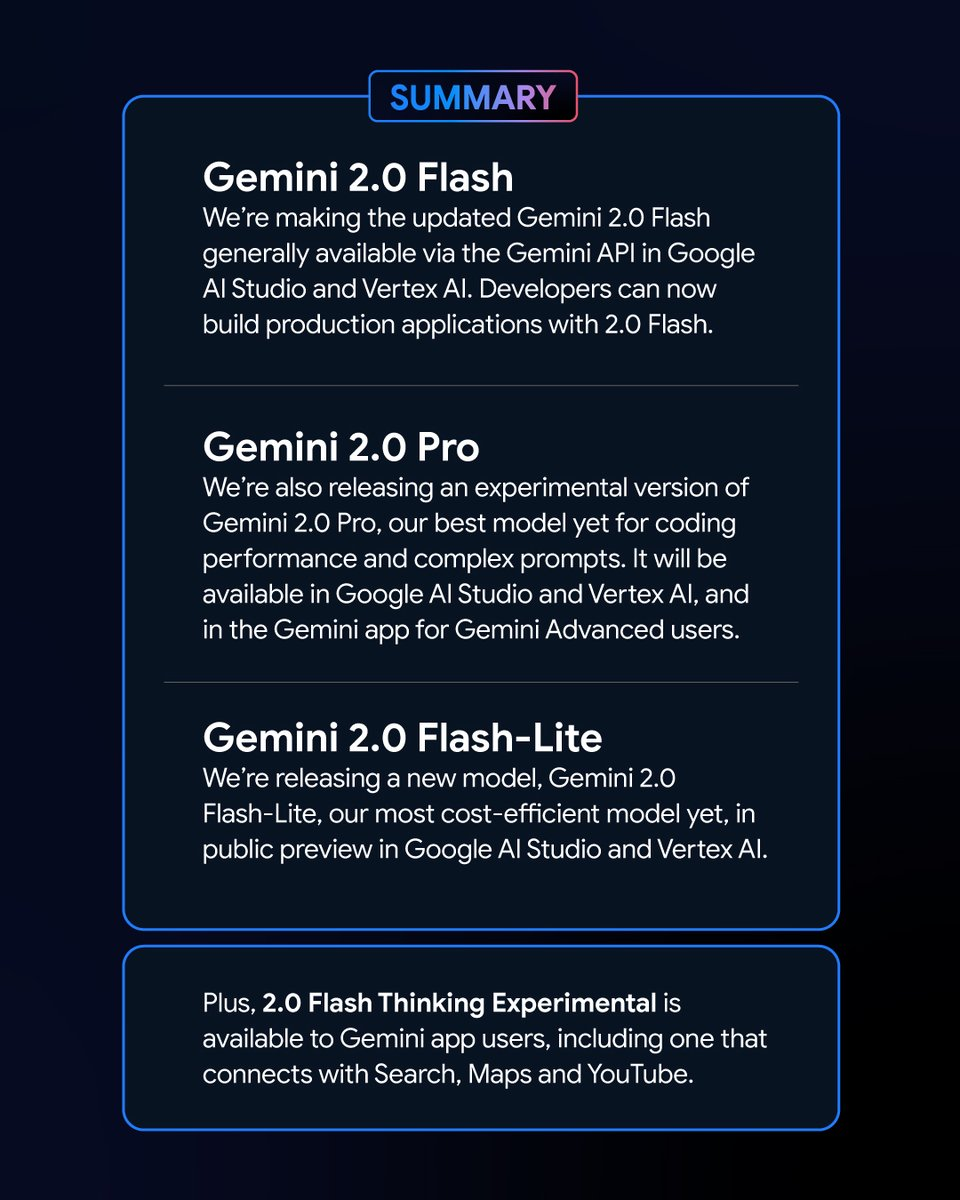

Nouvelle initiative de Google : les nouveaux membres de la série Gemini dévoilés

Au petit matin du 6 février, Google a lancé une série de nouvelles versions du modèle Gemini. Parmi elles, la version expérimentale de Gémeaux 2.0 La version Pro et la version d’aperçu de Gemini 2.0 Flash – Lite ont attiré beaucoup d’attention, et la dernière version de Gemini 2.0 Flash a été officiellement publiée.

En tant que nouvelle variante, Google Gemini 2.0 Flash – Lite a un prix très attractif de seulement 0,3 USD par million de jetons, ce qui en fait le modèle le plus abordable de Google à ce jour.

La version expérimentale de Gemini 2.0 Pro, quant à elle, dispose de puissantes capacités multimodales natives capables de convertir entre le texte, l'audio et la vidéo.

La version expérimentale de Gemini 2.0 Flash Thinking est gratuite et offre également la possibilité d'accéder, d'extraire et de résumer le contenu des vidéos YouTube.

Logan Kilpatrick, responsable des produits Google AI Studio, a annoncé sur la plateforme X que ces modèles sont « les modèles les plus puissants de l'histoire de Google » et sont disponibles pour tous les développeurs.

Les performances et les résultats impressionnants des nouveaux modèles Gemini dans le classement

Dans le classement des grands modèles de Chatbot Arena, les éditions expérimentales Gemini 2.0 Flash Thinking et Gemini 2.0 Pro Experimental ont obtenu des résultats exceptionnels. Par rapport aux précédents grands modèles de Google, Gemini 2.0 a fait de grands progrès et, sans surprise, il a réussi à atteindre le sommet du classement, avec un score combiné dépassant ChatGPT-4o et DeepSeek-R1. C'est une énorme amélioration.

Ce résultat est basé sur une évaluation complète des capacités de grands modèles dans divers domaines, notamment les mathématiques, le codage et le traitement multilingue.

Prix et performances : chaque variante de Gemini 2.0 a ses propres avantages

Les différentes versions de Gemini 2.0 ont leurs propres caractéristiques en termes de prix et de performances. Un équilibre entre performances et prix a été atteint, offrant aux utilisateurs plus de choix. Les API des différentes versions de Gemini 2.0 peuvent être appelées via Google AI Studio et Vertex AI. Les développeurs et les utilisateurs peuvent choisir la version appropriée en fonction de leurs besoins.

Gemini 2.0 a fait de grands progrès et a beaucoup évolué par rapport à Gemini 1.5. Bien que les différentes versions de Gemini 2.0 présentent des différences, elles ont toutes été globalement améliorées. Plus précisément, vous devez déterminer le scénario que vous utilisez, puis vous pourrez mieux choisir le modèle Gemini qui vous convient.

En termes de prix, Gemini 2.0 Flash et Gemini 2.0 Flash – Lite se concentrent sur un déploiement léger. Ils prennent en charge jusqu'à 1 million de jetons dans la longueur de la fenêtre de contexte, et en termes de prix, la distinction entre le traitement de texte long et court dans Gemini 1.5 Flash a été supprimée et le prix est unifié à un prix unitaire de jeton.

Gemini 2.0 Flash coûte 0,4 USD par million de jetons pour la sortie de texte, soit la moitié du prix de Gemini 1.5 Flash lors du traitement de textes longs.

Gemini 2.0 Flash – Lite est encore meilleur en termes d’optimisation des coûts dans les scénarios de sortie de texte à grande échelle, avec un prix de sortie de texte de 0,3 USD par million de jetons. Même le PDG de Google, Sundar Pichai, l’a salué comme « efficace et puissant ».

En termes d'amélioration des performances, Gemini 2.0 Flash dispose de fonctions d'interaction multimodale plus complètes que la version Lite. Il est prévu de prendre en charge la sortie d'images, ainsi que l'entrée et la sortie bidirectionnelles en temps réel à faible latence de modalités telles que le texte, l'audio et la vidéo.

La version expérimentale de Gemini 2.0 Pro excelle en termes de performances d'encodage et d'invites complexes. Sa fenêtre de contexte peut atteindre jusqu'à 2 millions de jetons et sa capacité générale est passée de 75,8% à 79,1% par rapport à la génération précédente, ce qui constitue une différence significative dans la capacité d'encodage et de raisonnement avec Gemini 2.0 Flash et Gemini 2.0 Flash – Lite.

L'équipe de l'application Gemini a déclaré sur la plate-forme X que les utilisateurs de Gemini Advanced peuvent accéder à la version expérimentale de Gemini 2.0 Pro via le menu déroulant du modèle, et la version expérimentale de Gemini 2.0 Flash Thinking est gratuite pour les utilisateurs de l'application Gemini, et cette version peut être utilisée en conjonction avec YouTube, la recherche Google et Google Maps.

Contrer la concurrence : concours de rentabilité du modèle Google

À l’heure où le coût de développement des modèles est devenu un sujet brûlant dans l’industrie, le lancement du DeepSeek – R1 open source, à faible coût et à hautes performances a eu un impact sur l’ensemble de l’industrie.

Lors de la conférence téléphonique après la publication du rapport financier du quatrième trimestre 2024 de Google, Pichai, tout en reconnaissant les réalisations de DeepSeek, a également souligné que la série de modèles Gemini est leader dans l'équilibre entre coût, performances et latence, et que leurs performances globales sont meilleures que celles des modèles V3 et R1 de DeepSeek.

Du point de vue du classement du test de performance des grands modèles LiveBench réalisé par Yang Likun et son équipe, le classement général de Gemini 2.0 Flash est supérieur à celui de DeepSeek V3 et d'o1-mini d'OpenAI, mais il est derrière DeepSeek-R1 et d'o1 d'OpenAI. Cependant, le lancement de Gemini 2.0 Flash-Lite par Google est comme un atout. Google espère rendre les derniers grands modèles abordables pour plus de personnes, réduire les coûts d'utilisation des utilisateurs et espérer occuper une place dans la concurrence entre les entreprises pour le rapport prix/performance.

Après que Google a publié le dernier Gemini 2.0, un internaute a commencé à essayer d'analyser Gemini 2.0 Flash et d'autres modèles populaires deepseek et openai GPT-4o par lui-même. Il a découvert que la nouvelle version de Gemini 2.0 Flash surpasse les deux autres modèles en termes de performances et de coût. Cela nous donne également un aperçu du développement et de l'évolution de Google, et c'est un bon début.

Plus précisément, Gemini 2.0 Flash coûte 0,1 USD par million de jetons en entrée et 0,4 USD en sortie, ce qui est bien inférieur à DeepSeek V3. Il s'agit d'une amélioration et d'un développement considérables. L'internaute a également souligné sur la plateforme X : « La version officielle de Gemini 2.0 Flash coûte un tiers du GPT-4o-mini, alors qu'elle est trois fois plus rapide. »

Nouvelle tendance sur le marché des grands modèles : le rapport qualité/prix est roi

Aujourd'hui, le secteur des grands modèles est pris dans une nouvelle guerre des prix. Dans le passé, le coût élevé de l'utilisation des grands modèles a créé une certaine résistance à leur utilisation et à leur promotion. L'impact de la guerre des prix des grands modèles déclenchée par DeepSeek sur le marché des grands modèles à l'étranger continue de fermenter. Dans le même temps, l'option open source a également permis à davantage d'utilisateurs de comprendre et d'utiliser les derniers résultats de recherche sur les grands modèles. La stratégie open source + bas prix a également mis la pression sur de nombreuses grandes entreprises américaines de modèles.

Google a lancé Gemini 2.0 Flash-Lite et OpenAI a mis gratuitement à disposition de tous les utilisateurs la fonction de recherche ChatGPT, afin que ces derniers puissent utiliser la fonction de recherche pour effectuer des tâches plus diverses. L'équipe interne de Meta intensifie également ses recherches sur les stratégies de réduction des prix des grands modèles tout en promouvant le développement ultérieur des grands modèles open source de Meta.

Dans ce secteur hautement concurrentiel, aucune entreprise ne peut se maintenir confortablement à la première place. Les entreprises tentent d'attirer et de fidéliser les utilisateurs en améliorant la rentabilité. Cette tendance aidera les grands modèles à passer du développement technologique pur à une application plus large, et le futur marché des grands modèles continuera d'évoluer et de changer dans la concurrence pour la rentabilité.