대규모 AI 모델을 사용하는 데 드는 높은 비용은 많은 AI 애플리케이션이 아직 구현 및 홍보되지 않은 주요 이유입니다. 극한의 성능을 선택하면 엄청난 컴퓨팅 전력 비용이 발생하여 일반 사용자가 감당할 수 없는 높은 사용 비용이 발생합니다.

대형 AI 모델을 위한 경쟁은 연기 없는 전쟁과 같습니다. DeepSeek가 최신 R1 대형 모델을 출시하고 오픈 소스로 공개한 후, OpenAI도 압박 속에서 최신 o3 모델을 출시했습니다. 대형 모델 플레이어인 Google도 저비용 모델을 위한 치열한 경쟁에 합류해야 했습니다.

구글의 새로운 움직임: 제미니 시리즈의 새로운 멤버들 공개

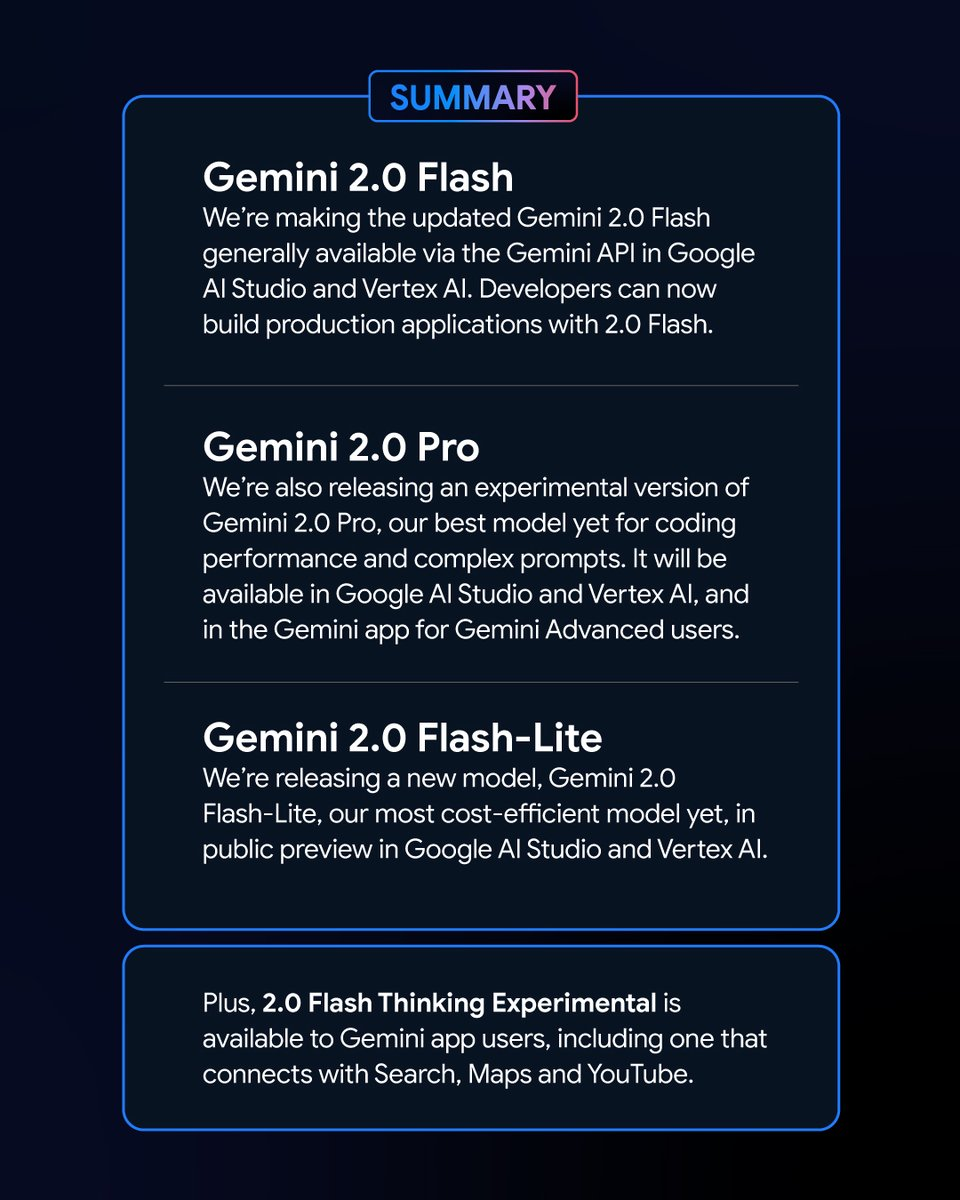

2월 6일 이른 아침, 구글은 제미니 모델의 새로운 버전 시리즈를 출시했습니다. 그 중 실험 버전은 쌍둥이자리 2.0 Gemini 2.0 Flash – Lite의 Pro와 미리보기 버전은 많은 관심을 끌었으며, Gemini 2.0 Flash의 최신 버전이 공식 출시되었습니다.

새로운 변종으로서, 구글 제미니 2.0 Flash – Lite는 토큰 100만 개당 0.3달러라는 매우 매력적인 가격을 자랑하며, 현재까지 Google이 출시한 모델 중 가장 저렴한 모델입니다.

반면, Gemini 2.0 Pro의 실험 버전은 텍스트와 오디오, 비디오를 변환할 수 있는 강력한 기본 멀티모달 기능을 갖추고 있습니다.

Gemini 2.0 Flash Thinking의 실험 버전은 무료로 사용할 수 있으며 YouTube 동영상 콘텐츠에 접근하여 추출하고 요약하는 기능도 있습니다.

Google AI Studio 제품 책임자인 로건 킬패트릭은 X 플랫폼에서 이러한 모델이 "Google 역사상 가장 강력한 모델"이며 모든 개발자가 사용할 수 있다고 발표했습니다.

새로운 제미니 모델의 인상적인 성능과 리더보드 결과

Chatbot Arena 대형 모델 리더보드에서 Gemini 2.0 Flash Thinking Experimental Edition과 Gemini 2.0 Pro Experimental Edition은 뛰어난 성과를 거두었습니다. 이전 Google 대형 모델과 비교했을 때 Gemini 2.0은 큰 진전을 이루었고, 놀랍지 않게도 리더보드 정상에 성공적으로 올랐으며, 합산 점수는 ChatGPT-4o와 DeepSeek-R1을 능가했습니다. 이는 엄청난 개선입니다.

이 결과는 수학, 코딩, 다국어 처리를 포함한 다양한 분야에서 대규모 모델의 역량을 종합적으로 평가한 데 따른 것입니다.

가격 및 성능: Gemini 2.0의 각 변형에는 고유한 장점이 있습니다.

Gemini 2.0의 다양한 버전은 가격과 성능 면에서 고유한 특성을 가지고 있습니다. 성능과 가격의 균형이 이루어졌으며, 사용자에게 더 많은 선택권을 제공합니다. Gemini 2.0의 다양한 버전의 API는 Google AI Studio와 Vertex AI를 통해 호출할 수 있습니다. 개발자와 사용자는 필요에 따라 적절한 버전을 선택할 수 있습니다.

Gemini 2.0은 Gemini 1.5에 비해 큰 진전과 발전을 이루었습니다. Gemini 2.0의 다른 버전에는 차이가 있지만, 전반적으로 모두 개선되었습니다. 구체적으로, 사용하는 시나리오를 결정해야 하며, 그러면 자신에게 맞는 Gemini 모델을 더 잘 선택할 수 있습니다.

가격 측면에서 Gemini 2.0 Flash와 Gemini 2.0 Flash – Lite는 가벼운 배포에 초점을 맞춥니다. 컨텍스트 창의 길이에서 최대 100만 개의 토큰을 지원하고, 가격 측면에서 Gemini 1.5 Flash의 긴 텍스트 처리와 짧은 텍스트 처리의 구분이 제거되었으며, 가격은 단위 토큰 가격으로 통합되었습니다.

Gemini 2.0 Flash는 텍스트 출력을 위해 백만 개의 토큰당 0.4달러의 비용이 듭니다. 이는 긴 텍스트를 처리할 때 Gemini 1.5 Flash의 절반 가격입니다.

Gemini 2.0 Flash – Lite는 대규모 텍스트 출력 시나리오에서 비용 최적화에 더욱 뛰어나며, 텍스트 출력 가격은 백만 토큰당 0.3 USD입니다. Google CEO Sundar Pichai조차도 "효율적이고 강력하다"고 칭찬했습니다.

성능 개선 측면에서 Gemini 2.0 Flash는 Lite 버전보다 더 포괄적인 멀티모달 상호작용 기능을 제공합니다. 이미지 출력은 물론 텍스트, 오디오, 비디오와 같은 모달리티의 양방향 실시간 저지연 입출력을 지원할 예정입니다.

Gemini 2.0 Pro의 실험 버전은 인코딩 성능과 복잡한 프롬프트 측면에서 뛰어납니다. 컨텍스트 창은 최대 200만 토큰에 도달할 수 있으며, 일반 기능은 이전 세대에 비해 75.8%에서 79.1%로 증가했습니다. 이는 Gemini 2.0 Flash와 Gemini 2.0 Flash – Lite의 인코딩 및 추론 기능에서 상당한 차이입니다.

제미니 애플리케이션 팀은 X 플랫폼에서 제미니 고급 사용자는 모델 드롭다운 메뉴를 통해 제미니 2.0 Pro 실험 버전에 액세스할 수 있으며, 제미니 2.0 플래시 씽킹 실험 버전은 제미니 애플리케이션 사용자에게 무료로 제공되며, 이 버전은 YouTube, Google 검색, Google 지도와 함께 사용할 수 있다고 밝혔습니다.

경쟁 대응: 구글 모델 비용 효율성 경연 대회

모델 개발 비용이 업계의 주요 이슈가 된 시점에, 오픈 소스, 저비용, 고성능 DeepSeek-R1의 출시는 업계 전체에 영향을 미쳤습니다.

구글의 2024년 4분기 재무 보고서 발표 후 컨퍼런스 콜에서 피차이는 DeepSeek의 성과를 인정하는 동시에 제미니 시리즈 모델이 비용, 성능, 지연 시간 간의 균형에서 앞서고 있으며, 전반적인 성능이 DeepSeek의 V3 및 R1 모델보다 우수하다고 강조했습니다.

양리쿤과 그의 팀이 구축한 LiveBench 대형 모델 성능 벤치마크 테스트의 순위를 보면, Gemini 2.0 Flash의 전체 순위는 DeepSeek V3와 OpenAI의 o1-mini보다 높지만, DeepSeek-R1과 OpenAI의 o1에는 뒤처져 있습니다. 하지만 Google의 Gemini 2.0 Flash-Lite 출시는 트럼프 카드와 같습니다. Google은 최신 대형 모델을 더 많은 사람들이 구매할 수 있게 하고, 사용자의 사용 비용을 줄이고, 가격/성능 면에서 기업 간 경쟁에서 자리를 차지하기를 바랍니다.

Google이 출시한 후 최신 Gemini 2.0, 네티즌이 Gemini 2.0 Flash와 다른 인기 있는 deepseek 및 openai GPT-4o 모델을 직접 분석하기 시작했습니다. 그는 Gemini 2.0 Flash의 새 버전이 성능과 비용 면에서 다른 두 모델을 능가한다는 것을 발견했습니다. 이는 또한 Google의 개발 및 진화를 엿볼 수 있게 해주며 좋은 시작입니다.

구체적으로, Gemini 2.0 Flash는 입력에 대해 백만 토큰당 0.1 USD, 출력에 대해 0.4 USD로 비용이 들며, 둘 다 DeepSeek V3보다 훨씬 낮습니다. 이는 엄청난 개선 및 개발입니다. 네티즌은 또한 X 플랫폼에서 "Gemini 2.0 Flash의 공식 버전은 GPT-4o-mini의 1/3에 불과하지만 속도는 3배 더 빠릅니다."라고 지적했습니다.

대형 모델 시장의 새로운 트렌드: 가성비가 최고

오늘날 대형 모델 분야는 새로운 가격 전쟁에 휘말렸습니다. 과거에는 대형 모델을 사용하는 데 드는 비용이 높아 사용 및 홍보에 대한 저항이 있었습니다. DeepSeek가 촉발한 대형 모델 가격 전쟁이 해외 대형 모델 시장에 미치는 영향은 여전히 계속되고 있습니다. 동시에 오픈 소스 옵션을 통해 더 많은 사용자가 최신 대형 모델 연구 결과를 이해하고 사용할 수 있게 되었습니다. 오픈 소스 + 저가 전략은 또한 많은 미국 대형 모델 회사에 압력을 가했습니다.

Google은 Gemini 2.0 Flash-Lite를 출시했고, OpenAI는 모든 사용자에게 ChatGPT 검색 기능을 무료로 제공하여 사용자가 검색 기능을 사용하여 더 다양한 작업을 완료할 수 있도록 했습니다. Meta 내부 팀도 Meta의 오픈 소스 대형 모델의 추가 개발을 촉진하는 동시에 대형 모델 가격 인하 전략에 대한 연구를 강화하고 있습니다.

경쟁이 치열한 이 분야에서 어떤 회사도 1위 자리에 편안하게 앉을 수 없습니다. 회사들은 비용 효율성을 개선하여 사용자를 유치하고 유지하려고 노력하고 있습니다. 이러한 추세는 대형 모델이 순수한 기술 개발에서 더 광범위한 응용 분야로 이동하는 데 도움이 될 것이며, 미래의 대형 모델 시장은 비용 효율성을 위한 경쟁에서 계속 진화하고 변화할 것입니다.