Chi phí cao khi sử dụng các mô hình AI lớn là lý do chính khiến nhiều ứng dụng AI vẫn chưa được triển khai và thúc đẩy. Việc lựa chọn hiệu suất cực cao có nghĩa là chi phí năng lượng tính toán rất lớn, dẫn đến chi phí sử dụng cao mà người dùng thông thường không thể chấp nhận.

Cuộc cạnh tranh cho các mô hình AI lớn giống như một cuộc chiến không khói thuốc. Sau khi DeepSeek phát hành và mở mã nguồn cho mô hình lớn R1 mới nhất, OpenAI cũng phát hành mô hình o3 mới nhất của riêng mình dưới áp lực. Google, công ty sản xuất mô hình lớn cũng phải tham gia vào cuộc cạnh tranh khốc liệt cho các mô hình giá rẻ.

Động thái mới của Google: công bố thành viên mới của series Gemini

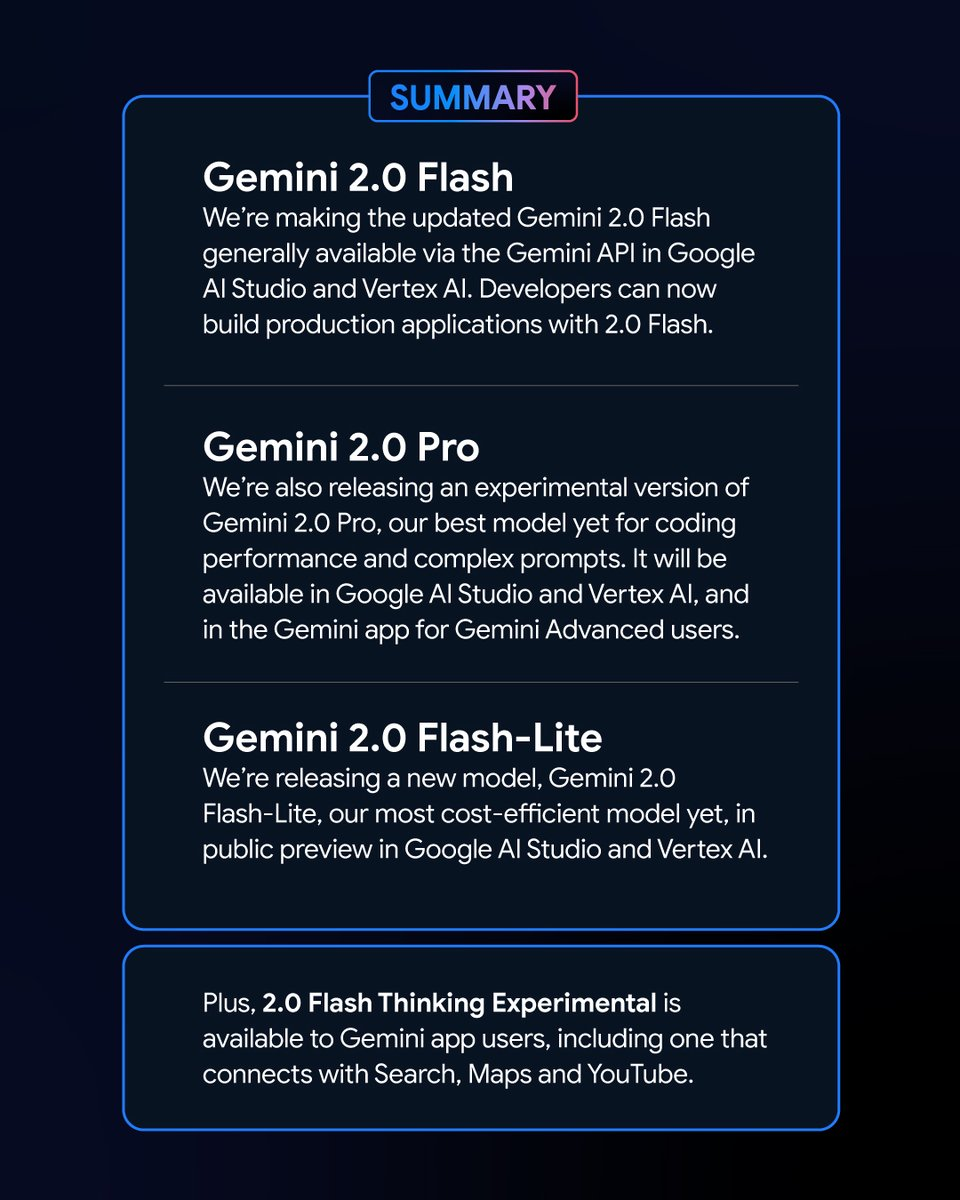

Vào sáng sớm ngày 6 tháng 2, Google đã tung ra một loạt các phiên bản mới của mô hình Gemini. Trong số đó, phiên bản thử nghiệm của Song Tử 2.0 Phiên bản Pro và bản xem trước của Gemini 2.0 Flash – Lite đã thu hút được nhiều sự chú ý và phiên bản mới nhất của Gemini 2.0 Flash đã chính thức được phát hành.

Là một biến thể mới, Google Gemini 2.0 Flash – Lite có mức giá rất hấp dẫn chỉ 0,3 USD cho một triệu token, khiến đây trở thành mô hình có giá cả phải chăng nhất của Google cho đến nay.

Ngược lại, phiên bản thử nghiệm của Gemini 2.0 Pro có khả năng đa phương thức mạnh mẽ có thể chuyển đổi giữa văn bản, âm thanh và video.

Phiên bản thử nghiệm của Gemini 2.0 Flash Thinking miễn phí sử dụng và cũng có khả năng truy cập, trích xuất và tóm tắt nội dung video trên YouTube.

Logan Kilpatrick, người đứng đầu sản phẩm Google AI Studio, đã thông báo trên nền tảng X rằng các mô hình này là “những mô hình mạnh mẽ nhất trong lịch sử Google” và dành cho tất cả các nhà phát triển.

Hiệu suất ấn tượng của các mẫu xe Gemini mới và kết quả trên bảng xếp hạng

Trong Bảng xếp hạng mô hình lớn Chatbot Arena, Gemini 2.0 Flash Thinking Experimental Edition và Gemini 2.0 Pro Experimental Edition đã đạt được kết quả vượt trội. So với các mô hình lớn trước đây của Google, Gemini 2.0 đã có những tiến bộ vượt bậc và không có gì ngạc nhiên khi chúng đã thành công vươn lên vị trí đầu bảng xếp hạng, với tổng điểm vượt qua ChatGPT-4o và DeepSeek-R1. Đây là một cải tiến rất lớn.

Kết quả này dựa trên đánh giá toàn diện về khả năng của các mô hình lớn trong nhiều lĩnh vực, bao gồm toán học, mã hóa và xử lý đa ngôn ngữ.

Giá cả và hiệu suất: mỗi phiên bản của Gemini 2.0 đều có những ưu điểm riêng

Các phiên bản khác nhau của Gemini 2.0 có những đặc điểm riêng về giá cả và hiệu suất. Sự cân bằng giữa hiệu suất và giá cả đã đạt được, mang đến cho người dùng nhiều lựa chọn hơn. API của các phiên bản khác nhau của Gemini 2.0 có thể được gọi thông qua Google AI Studio và Vertex AI. Các nhà phát triển và người dùng có thể chọn phiên bản phù hợp theo nhu cầu của họ.

Gemini 2.0 đã có những tiến bộ và phát triển vượt bậc so với Gemini 1.5. Mặc dù các phiên bản Gemini 2.0 khác nhau có sự khác biệt, nhưng nhìn chung tất cả đều được cải thiện. Cụ thể, bạn cần xác định kịch bản mình đang sử dụng, sau đó bạn có thể lựa chọn mô hình Gemini phù hợp hơn.

Về giá cả, Gemini 2.0 Flash và Gemini 2.0 Flash – Lite tập trung vào triển khai nhẹ. Chúng hỗ trợ tối đa 1 triệu token trong chiều dài của cửa sổ ngữ cảnh và về giá cả, sự khác biệt giữa xử lý văn bản dài và ngắn trong Gemini 1.5 Flash đã bị xóa bỏ và giá được thống nhất ở mức giá token đơn vị.

Gemini 2.0 Flash có giá 0,4 USD cho một triệu token để xuất văn bản, chỉ bằng một nửa giá của Gemini 1.5 Flash khi xử lý các văn bản dài.

Gemini 2.0 Flash – Lite thậm chí còn tốt hơn về mặt tối ưu hóa chi phí trong các kịch bản đầu ra văn bản quy mô lớn, với giá đầu ra văn bản là 0,3 đô la Mỹ cho một triệu token. Ngay cả CEO của Google Sundar Pichai cũng ca ngợi nó là “hiệu quả và mạnh mẽ”.

Về mặt cải thiện hiệu suất, Gemini 2.0 Flash có các chức năng tương tác đa phương thức toàn diện hơn so với phiên bản Lite. Nó được lên lịch để hỗ trợ đầu ra hình ảnh, cũng như đầu vào và đầu ra độ trễ thấp theo thời gian thực hai chiều của các phương thức như văn bản, âm thanh và video.

Phiên bản thử nghiệm của Gemini 2.0 Pro vượt trội về hiệu suất mã hóa và lời nhắc phức tạp. Cửa sổ ngữ cảnh của nó có thể đạt tới 2 triệu mã thông báo và khả năng chung của nó đã tăng từ 75.8% lên 79.1% so với thế hệ trước, đây là sự khác biệt đáng kể về khả năng mã hóa và suy luận với Gemini 2.0 Flash và Gemini 2.0 Flash – Lite.

Nhóm ứng dụng Gemini cho biết trên nền tảng X rằng người dùng Gemini Advanced có thể truy cập phiên bản thử nghiệm Gemini 2.0 Pro thông qua menu thả xuống mô hình và phiên bản thử nghiệm Gemini 2.0 Flash Thinking miễn phí cho người dùng ứng dụng Gemini và phiên bản này có thể sử dụng cùng với YouTube, Google tìm kiếm và Google Maps.

Đối phó với cạnh tranh: Cuộc thi hiệu quả chi phí mô hình của Google

Vào thời điểm chi phí phát triển mô hình trở thành chủ đề nóng trong ngành, việc ra mắt DeepSeek – R1 mã nguồn mở, chi phí thấp, hiệu suất cao đã tác động đến toàn bộ ngành.

Trong cuộc gọi hội nghị sau khi Google công bố báo cáo tài chính quý 4 năm 2024, Pichai, mặc dù thừa nhận những thành tựu của DeepSeek, cũng nhấn mạnh rằng dòng sản phẩm Gemini đang dẫn đầu về sự cân bằng giữa chi phí, hiệu suất và độ trễ, và hiệu suất tổng thể của chúng tốt hơn so với các mẫu V3 và R1 của DeepSeek.

Theo góc nhìn về thứ hạng của bài kiểm tra chuẩn hiệu suất mô hình lớn LiveBench do Yang Likun và nhóm của ông xây dựng, thứ hạng chung của Gemini 2.0 Flash cao hơn so với DeepSeek V3 và o1 – mini của OpenAI, nhưng vẫn đứng sau DeepSeek – R1 và o1 của OpenAI. Tuy nhiên, việc Google ra mắt Gemini 2.0 Flash – Lite giống như một lá bài chủ. Google hy vọng sẽ làm cho các mô hình lớn mới nhất trở nên phù hợp với nhiều người hơn, giảm chi phí sử dụng của người dùng và hy vọng sẽ chiếm một vị trí trong cuộc cạnh tranh giữa các công ty về giá cả/hiệu suất.

Sau khi Google phát hành Gemini 2.0 mới nhất, một cư dân mạng đã bắt đầu thử và tự mình phân tích Gemini 2.0 Flash và các mô hình deepseek và openai GPT-4o phổ biến khác. Anh ấy thấy rằng phiên bản mới của Gemini 2.0 Flash vượt trội hơn hai mô hình kia về cả hiệu suất và chi phí. Điều này cũng cho chúng ta cái nhìn thoáng qua về sự phát triển và tiến hóa của Google, và đó là một khởi đầu tốt.

Cụ thể, Gemini 2.0 Flash có giá 0,1 USD cho một triệu token đầu vào và 0,4 USD cho đầu ra, cả hai đều thấp hơn nhiều so với DeepSeek V3. Đây là một cải tiến và phát triển rất lớn. Cư dân mạng cũng chỉ ra trên nền tảng X: “Phiên bản chính thức của Gemini 2.0 Flash có giá bằng một phần ba GPT-4o-mini, trong khi tốc độ nhanh gấp ba lần”.

Một xu hướng mới trên thị trường mô hình lớn: giá trị đồng tiền là vua

Ngày nay, lĩnh vực mô hình lớn đang bị cuốn vào một cuộc chiến giá mới. Trước đây, chi phí cao khi sử dụng các mô hình lớn đã tạo ra một số sự phản kháng đối với việc sử dụng và quảng bá chúng. Tác động của cuộc chiến giá đối với các mô hình lớn do DeepSeek gây ra đối với thị trường mô hình lớn ở nước ngoài vẫn đang tiếp tục lên men. Đồng thời, tùy chọn nguồn mở cũng cho phép nhiều người dùng hơn hiểu và sử dụng các kết quả nghiên cứu mô hình lớn mới nhất. Chiến lược nguồn mở + giá thấp cũng gây áp lực lên nhiều công ty mô hình lớn của Mỹ.

Google đã ra mắt Gemini 2.0 Flash-Lite và OpenAI đã cung cấp miễn phí chức năng tìm kiếm ChatGPT cho tất cả người dùng, để người dùng có thể sử dụng chức năng tìm kiếm để hoàn thành nhiều tác vụ đa dạng hơn. Nhóm nội bộ Meta cũng đang đẩy mạnh nghiên cứu về các chiến lược giảm giá mô hình lớn đồng thời thúc đẩy phát triển hơn nữa các mô hình lớn nguồn mở của Meta.

Trong lĩnh vực cạnh tranh cao này, không công ty nào có thể ngồi thoải mái ở vị trí số một. Các công ty đang cố gắng thu hút và giữ chân người dùng bằng cách cải thiện hiệu quả chi phí. Xu hướng này sẽ giúp các mô hình lớn chuyển từ phát triển công nghệ thuần túy sang ứng dụng rộng rãi hơn và thị trường mô hình lớn trong tương lai sẽ tiếp tục phát triển và thay đổi trong cuộc cạnh tranh về hiệu quả chi phí.