Die hohen Kosten für die Verwendung großer KI-Modelle sind ein Hauptgrund dafür, dass viele KI-Anwendungen noch nicht implementiert und gefördert wurden. Die Wahl extremer Leistung bedeutet enorme Kosten für die Rechenleistung, was zu hohen Nutzungskosten führt, die normale Benutzer nicht akzeptieren können.

Der Wettbewerb um große KI-Modelle gleicht einem Krieg ohne Rauch. Nachdem DeepSeek das neueste große R1-Modell veröffentlicht und als Open Source freigegeben hatte, veröffentlichte OpenAI unter Druck auch sein eigenes neuestes O3-Modell. Auch der große Modellanbieter Google musste sich dem harten Wettbewerb um kostengünstige Modelle anschließen.

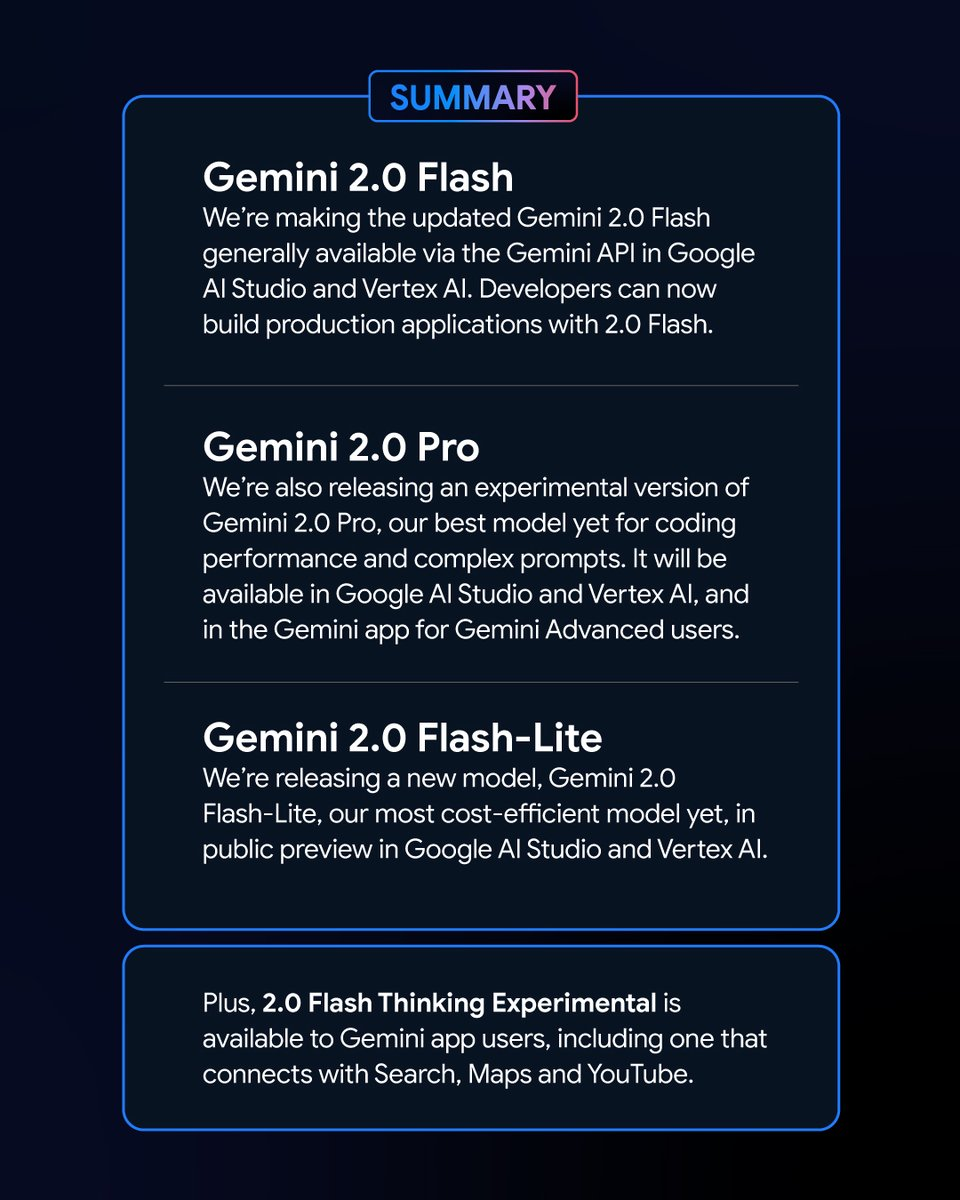

Googles neuer Schritt: Neue Mitglieder der Gemini-Serie vorgestellt

Am frühen Morgen des 6. Februar veröffentlichte Google eine Reihe neuer Versionen des Gemini-Modells. Darunter die experimentelle Version von Zwilling 2.0 Pro und die Vorschauversion von Gemini 2.0 Flash – Lite erregten viel Aufmerksamkeit und die neueste Version von Gemini 2.0 Flash wurde offiziell veröffentlicht.

Als neue Variante Google Gemini 2.0 Flash-Lite hat einen sehr attraktiven Preis von nur 0,3 USD pro Million Token und ist damit das bislang günstigste Modell von Google.

Die experimentelle Version von Gemini 2.0 Pro verfügt dagegen über leistungsstarke native multimodale Funktionen, die zwischen Text und Audio und Video konvertieren können.

Die experimentelle Version von Gemini 2.0 Flash Thinking ist kostenlos nutzbar und bietet auch die Möglichkeit, auf den Inhalt von YouTube-Videos zuzugreifen, diese zu extrahieren und zusammenzufassen.

Logan Kilpatrick, Leiter der Google AI Studio-Produkte, gab auf der X-Plattform bekannt, dass diese Modelle „die leistungsstärksten Modelle in der Geschichte von Google“ seien und allen Entwicklern zur Verfügung stünden.

Die neuen Gemini-Modelle überzeugen durch ihre Leistung und Platzierungen in der Bestenliste

In der Bestenliste der Chatbot Arena-Großmodelle haben die Gemini 2.0 Flash Thinking Experimental Edition und die Gemini 2.0 Pro Experimental Edition hervorragende Ergebnisse erzielt. Im Vergleich zu früheren großen Google-Modellen hat Gemini 2.0 große Fortschritte gemacht und es überrascht nicht, dass sie erfolgreich die Spitze der Bestenliste erreicht haben, mit einer Gesamtpunktzahl, die ChatGPT-4o und DeepSeek-R1 übertrifft. Das ist eine enorme Verbesserung.

Dieses Ergebnis basiert auf einer umfassenden Bewertung der Fähigkeiten großer Modelle in verschiedenen Bereichen, darunter Mathematik, Codierung und mehrsprachige Verarbeitung.

Preis und Leistung: Jede Variante von Gemini 2.0 hat ihre eigenen Vorteile

Die verschiedenen Versionen von Gemini 2.0 haben ihre eigenen Merkmale in Bezug auf Preis und Leistung. Es wurde ein Gleichgewicht zwischen Leistung und Preis erreicht, wodurch den Benutzern mehr Auswahlmöglichkeiten geboten werden. Die APIs der verschiedenen Versionen von Gemini 2.0 können über Google AI Studio und Vertex AI aufgerufen werden. Entwickler und Benutzer können je nach Bedarf die entsprechende Version auswählen.

Gemini 2.0 hat im Vergleich zu Gemini 1.5 große Fortschritte und Entwicklungen gemacht. Obwohl die verschiedenen Versionen von Gemini 2.0 Unterschiede aufweisen, wurden sie alle insgesamt verbessert. Insbesondere müssen Sie das von Ihnen verwendete Szenario bestimmen, und dann können Sie besser das für Sie geeignete Gemini-Modell auswählen.

In Bezug auf den Preis konzentrieren sich Gemini 2.0 Flash und Gemini 2.0 Flash – Lite auf eine leichte Bereitstellung. Sie unterstützen bis zu 1 Million Token in der Länge des Kontextfensters, und in Bezug auf die Preisgestaltung wurde die Unterscheidung zwischen langer und kurzer Textverarbeitung in Gemini 1.5 Flash aufgehoben und der Preis auf einen Token-Einheitspreis vereinheitlicht.

Für die Textausgabe kostet Gemini 2.0 Flash 0,4 USD pro Million Token, was bei der Verarbeitung langer Texte der Hälfte des Preises von Gemini 1.5 Flash entspricht.

Gemini 2.0 Flash – Lite ist bei der Kostenoptimierung in groß angelegten Textausgabeszenarien sogar noch besser, mit einem Textausgabepreis von 0,3 USD pro Million Token. Sogar Google-CEO Sundar Pichai lobte es als „effizient und leistungsstark“.

In Bezug auf die Leistungsverbesserung verfügt Gemini 2.0 Flash über umfassendere multimodale Interaktionsfunktionen als die Lite-Version. Es soll Bildausgabe sowie bidirektionale Echtzeit-Ein- und Ausgabe von Modalitäten wie Text, Audio und Video mit geringer Latenz unterstützen.

Die experimentelle Version von Gemini 2.0 Pro zeichnet sich durch hervorragende Kodierungsleistung und komplexe Eingabeaufforderungen aus. Sein Kontextfenster kann bis zu 2 Millionen Token erreichen und seine allgemeine Fähigkeit wurde im Vergleich zur vorherigen Generation von 75,8% auf 79,1% erhöht, was einen erheblichen Unterschied in der Kodierungs- und Argumentationsfähigkeit mit Gemini 2.0 Flash und Gemini 2.0 Flash – Lite darstellt.

Das Gemini-Anwendungsteam sagte auf der X-Plattform, dass Benutzer von Gemini Advanced über das Dropdown-Menü des Modells auf die experimentelle Version von Gemini 2.0 Pro zugreifen können und dass die experimentelle Version von Gemini 2.0 Flash Thinking für Benutzer der Gemini-Anwendung kostenlos ist und in Verbindung mit YouTube, der Google-Suche und Google Maps verwendet werden kann.

Gegen den Wettbewerb: Kosteneffizienz-Wettbewerb des Google-Modells

In einer Zeit, in der die Kosten der Modellentwicklung zu einem heißen Thema in der Branche geworden sind, hatte die Einführung des Open Source, kostengünstigen und leistungsstarken DeepSeek – R1 Auswirkungen auf die gesamte Branche.

Während der Telefonkonferenz nach der Veröffentlichung des Finanzberichts von Google für das vierte Quartal 2024 würdigte Pichai die Erfolge von DeepSeek, betonte aber auch, dass die Modelle der Gemini-Reihe hinsichtlich des Gleichgewichts zwischen Kosten, Leistung und Latenz führend seien und dass ihre Gesamtleistung besser sei als die der Modelle V3 und R1 von DeepSeek.

Aus der Perspektive des von Yang Likun und seinem Team erstellten LiveBench-Leistungsbenchmarktests für große Modelle ist die Gesamtplatzierung von Gemini 2.0 Flash höher als die von DeepSeek V3 und OpenAIs o1 – mini, liegt aber hinter DeepSeek – R1 und OpenAIs o1. Die Einführung von Gemini 2.0 Flash – Lite durch Google ist jedoch wie ein Trumpf. Google hofft, die neuesten großen Modelle für mehr Menschen erschwinglich zu machen, die Nutzungskosten der Benutzer zu senken und im Wettbewerb der Unternehmen um Preis und Leistung einen Platz einzunehmen.

Nach der Veröffentlichung des neuestes Gemini 2.0begann ein Internetnutzer, Gemini 2.0 Flash und andere beliebte deepseek- und Openai GPT-4o-Modelle auf eigene Faust zu analysieren. Er stellte fest, dass die neue Version von Gemini 2.0 Flash die beiden anderen Modelle sowohl in Bezug auf Leistung als auch Kosten übertrifft. Dies gibt uns auch einen Einblick in die Entwicklung und Evolution von Google und ist ein guter Anfang.

Konkret kostet Gemini 2.0 Flash 0,1 USD pro Million Token für die Eingabe und 0,4 USD für die Ausgabe, was beides weitaus weniger ist als bei DeepSeek V3. Dies ist eine enorme Verbesserung und Entwicklung. Der Netizen wies auch auf die X-Plattform hin: „Die offizielle Version von Gemini 2.0 Flash kostet ein Drittel von GPT-4o-mini, ist dabei aber dreimal so schnell.“

Neuer Trend im Großmodellmarkt: Das Preis-Leistungs-Verhältnis ist Trumpf

Heute ist der Bereich der Großmodelle in einen neuen Preiskampf verwickelt. In der Vergangenheit haben die hohen Kosten für die Verwendung großer Modelle zu einem gewissen Widerstand gegen deren Verwendung und Förderung geführt. Die Auswirkungen des durch DeepSeek ausgelösten Preiskampfs für große Modelle auf dem ausländischen Markt für Großmodelle sind noch immer im Gange. Gleichzeitig hat die Open-Source-Option auch mehr Benutzern ermöglicht, die neuesten Forschungsergebnisse für große Modelle zu verstehen und zu verwenden. Die Open-Source- + Niedrigpreisstrategie hat auch viele amerikanische Großmodellunternehmen unter Druck gesetzt.

Google hat Gemini 2.0 Flash-Lite herausgebracht und OpenAI hat die ChatGPT-Suchfunktion allen Benutzern kostenlos zur Verfügung gestellt, sodass Benutzer die Suchfunktion für vielfältigere Aufgaben verwenden können. Das interne Meta-Team intensiviert außerdem die Forschung zu Strategien zur Preissenkung bei großen Modellen und fördert gleichzeitig die Weiterentwicklung der Open-Source-Großmodelle von Meta.

In diesem hart umkämpften Bereich kann sich kein Unternehmen bequem auf dem ersten Platz niederlassen. Unternehmen versuchen, Benutzer durch eine Verbesserung der Kosteneffizienz anzuziehen und zu halten. Dieser Trend wird großen Modellen dabei helfen, von der reinen Technologieentwicklung zu einer breiteren Anwendung überzugehen, und der zukünftige Markt für große Modelle wird sich im Wettbewerb um Kosteneffizienz weiter entwickeln und verändern.