De hoge kosten van het gebruik van grote AI-modellen zijn een belangrijke reden waarom veel AI-toepassingen nog niet zijn geïmplementeerd en gepromoot. Kiezen voor extreme prestaties betekent enorme kosten voor rekenkracht, wat leidt tot hoge gebruikskosten die gewone gebruikers niet kunnen accepteren.

De concurrentie om grote AI-modellen is als een oorlog zonder rook. Nadat DeepSeek het nieuwste R1-grote model had uitgebracht en open source had gemaakt, bracht OpenAI onder druk ook zijn eigen nieuwste o3-model uit. Grote modelspeler Google moest ook meedoen aan de felle concurrentie om goedkope modellen.

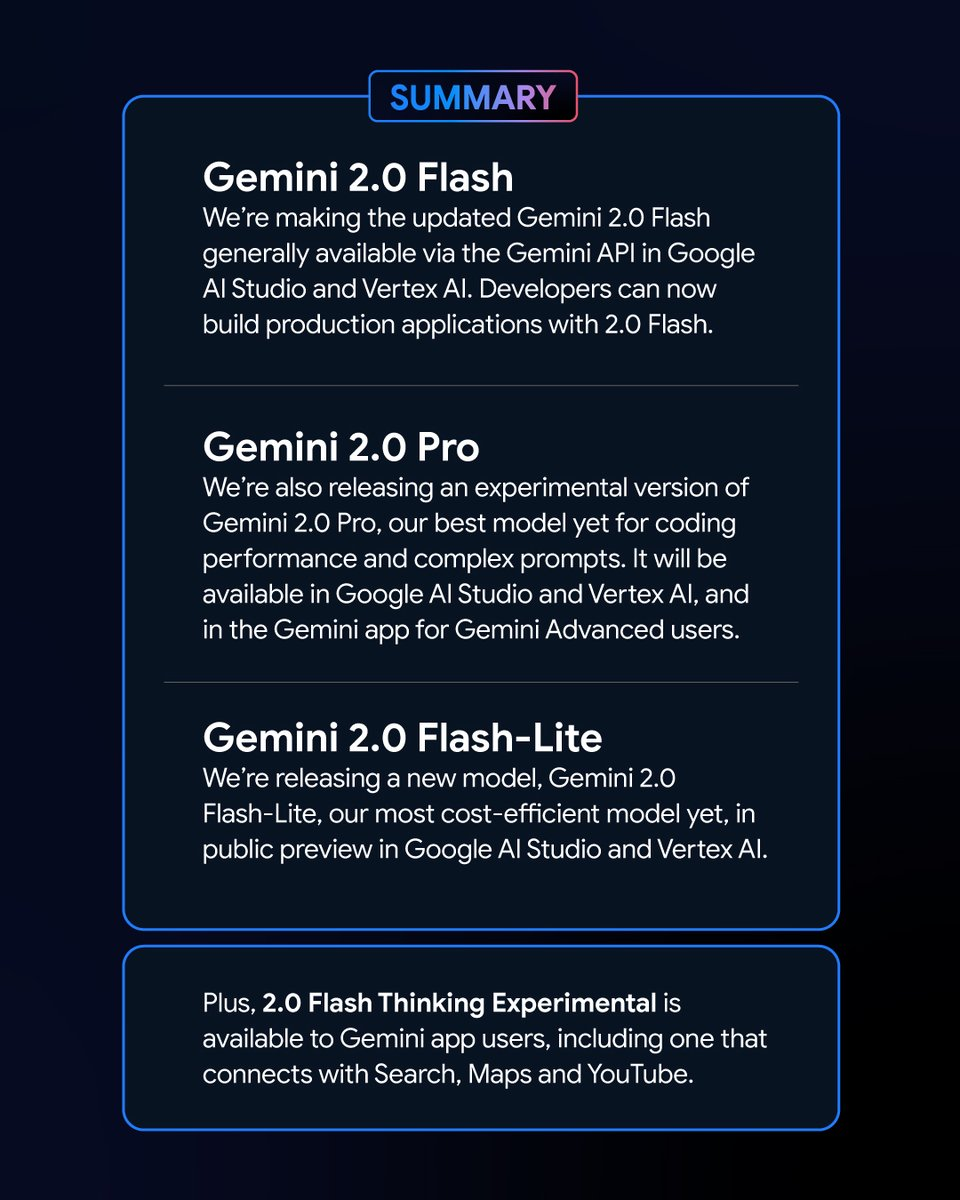

Nieuwe zet van Google: nieuwe leden van de Gemini-serie onthuld

In de vroege ochtend van 6 februari lanceerde Google een reeks nieuwe versies van het Gemini-model. Daaronder de experimentele versie van Tweelingen 2.0 Pro en de previewversie van Gemini 2.0 Flash – Lite trokken veel aandacht en de nieuwste versie van Gemini 2.0 Flash werd officieel uitgebracht.

Als nieuwe variant, Google Gemini 2.0 Flash – Lite heeft een zeer aantrekkelijke prijs van slechts 0,3 USD per miljoen tokens, wat het tot nu toe het meest betaalbare model van Google maakt.

De experimentele versie van Gemini 2.0 Pro beschikt daarentegen over krachtige native multimodale mogelijkheden die tekst, audio en video kunnen omzetten.

De experimentele versie van Gemini 2.0 Flash Thinking is gratis te gebruiken en biedt ook de mogelijkheid om de inhoud van YouTube-video's te openen, te extraheren en samen te vatten.

Logan Kilpatrick, hoofd van Google AI Studio-producten, kondigde op het X-platform aan dat deze modellen "de krachtigste modellen in de geschiedenis van Google" zijn en beschikbaar zijn voor alle ontwikkelaars.

De indrukwekkende prestaties en resultaten van de nieuwe Gemini-modellen in het klassement

In het Chatbot Arena Large Model Leaderboard hebben de Gemini 2.0 Flash Thinking Experimental Edition en Gemini 2.0 Pro Experimental Edition uitstekende resultaten behaald. Vergeleken met eerdere grote modellen van Google heeft Gemini 2.0 grote vooruitgang geboekt en het is geen verrassing dat ze met succes de top van het leaderboard hebben bereikt, met een gecombineerde score die ChatGPT-4o en DeepSeek-R1 overtreft. Dit is een enorme verbetering.

Deze resultaten zijn gebaseerd op een uitgebreide evaluatie van de mogelijkheden van grote modellen op verschillende gebieden, waaronder wiskunde, codering en meertalige verwerking.

Prijs en prestatie: elke variant van Gemini 2.0 heeft zijn eigen voordelen

De verschillende versies van Gemini 2.0 hebben hun eigen kenmerken qua prijs en prestatie. Er is een balans tussen prestatie en prijs bereikt, waardoor gebruikers meer keuzes hebben. De API's van de verschillende versies van Gemini 2.0 kunnen worden aangeroepen via Google AI Studio en Vertex AI. Ontwikkelaars en gebruikers kunnen de juiste versie kiezen op basis van hun behoeften.

Gemini 2.0 heeft grote vooruitgang en ontwikkeling geboekt vergeleken met Gemini 1.5. Hoewel de verschillende versies van Gemini 2.0 verschillen, zijn ze allemaal over het algemeen verbeterd. U moet met name het scenario bepalen dat u gebruikt, en dan kunt u beter het Gemini-model kiezen dat bij u past.

Qua prijs richten Gemini 2.0 Flash en Gemini 2.0 Flash – Lite zich op lichtgewicht implementatie. Ze ondersteunen tot 1 miljoen tokens in de lengte van het contextvenster en qua prijs is het onderscheid tussen lange en korte tekstverwerking in Gemini 1.5 Flash verwijderd en is de prijs geüniformeerd op een eenheidsprijs voor tokens.

Gemini 2.0 Flash kost 0,4 USD per miljoen tokens voor tekstuitvoer. Dit is de helft van de prijs van Gemini 1.5 Flash bij het verwerken van lange teksten.

Gemini 2.0 Flash – Lite is nog beter in kostenoptimalisatie in grootschalige tekstuitvoerscenario's, met een tekstuitvoerprijs van 0,3 USD per miljoen tokens. Zelfs Google CEO Sundar Pichai prees het als "efficiënt en krachtig".

In termen van prestatieverbetering heeft Gemini 2.0 Flash uitgebreidere multimodale interactiefuncties dan de Lite-versie. Het is gepland om beelduitvoer te ondersteunen, evenals bidirectionele real-time low-latency invoer en uitvoer van modaliteiten zoals tekst, audio en video.

De experimentele versie van Gemini 2.0 Pro blinkt uit in termen van coderingsprestaties en complexe prompts. Het contextvenster kan tot 2 miljoen tokens bereiken en de algemene mogelijkheid is toegenomen van 75.8% naar 79.1% vergeleken met de vorige generatie, wat een significant verschil is in coderings- en redeneervermogen met Gemini 2.0 Flash en Gemini 2.0 Flash – Lite.

Het Gemini-applicatieteam meldde op het X-platform dat Gemini Advanced-gebruikers toegang hebben tot de experimentele versie van Gemini 2.0 Pro via het model-dropdownmenu, en dat de experimentele versie van Gemini 2.0 Flash Thinking gratis is voor gebruikers van de Gemini-applicatie. Deze versie kan worden gebruikt in combinatie met YouTube, Google Zoeken en Google Maps.

Tegengaan van concurrentie: Google-model kosten-effectiviteitswedstrijd

In een tijd waarin de kosten van modelontwikkeling een hot topic zijn geworden in de industrie, heeft de lancering van de open source, goedkope, krachtige DeepSeek – R1 een impact gehad op de hele industrie.

Tijdens de telefonische vergadering na de publicatie van Google's financiële rapport voor het vierde kwartaal van 2024 erkende Pichai de prestaties van DeepSeek, maar benadrukte hij ook dat de Gemini-modellenreeks toonaangevend is op het gebied van de balans tussen kosten, prestaties en latentie, en dat hun algehele prestaties beter zijn dan die van de V3- en R1-modellen van DeepSeek.

Vanuit het perspectief van de rangschikking van de LiveBench large model performance benchmark test gebouwd door Yang Likun en zijn team, is de algehele rangschikking van Gemini 2.0 Flash hoger dan die van DeepSeek V3 en OpenAI's o1 – mini, maar het staat achter DeepSeek – R1 en OpenAI's o1. Echter, Google's lancering van Gemini 2.0 Flash – Lite is als een troefkaart. Google hoopt de nieuwste grote modellen betaalbaar te maken voor meer mensen, de gebruikskosten van gebruikers te verlagen en hoopt een plaats in te nemen in de concurrentiestrijd tussen bedrijven om prijs/prestatie.

Nadat Google de nieuwste Gemini 2.0, begon een netizen zelf te proberen Gemini 2.0 Flash en andere populaire deepseek en openai GPT-4o modellen te analyseren. Hij ontdekte dat de nieuwe versie van Gemini 2.0 Flash de andere twee modellen overtreft in termen van zowel prestaties als kosten. Dit geeft ons ook een glimp van Google's ontwikkeling en evolutie, en het is een goed begin.

Specifiek kost Gemini 2.0 Flash 0,1 USD per miljoen tokens voor input en 0,4 USD voor output, wat beide veel lager is dan DeepSeek V3. Dit is een enorme verbetering en ontwikkeling. De netizen wees er ook op op het X-platform: "De officiële versie van Gemini 2.0 Flash kost een derde van GPT-4o-mini, terwijl het drie keer zo snel is."

Een nieuwe trend op de markt voor grote modellen: waar voor je geld is koning

Tegenwoordig is het grote modelveld verwikkeld in een nieuwe prijzenoorlog. In het verleden hebben de hoge kosten van het gebruik van grote modellen enige weerstand tegen het gebruik en de promotie ervan gecreëerd. De impact van de prijzenoorlog voor grote modellen die door DeepSeek werd veroorzaakt op de overzeese markt voor grote modellen, blijft nog steeds gisten. Tegelijkertijd heeft de open source-optie ook meer gebruikers in staat gesteld om de nieuwste onderzoeksresultaten voor grote modellen te begrijpen en te gebruiken. De open source + lage prijsstrategie heeft ook druk uitgeoefend op veel Amerikaanse grote modelbedrijven.

Google lanceerde Gemini 2.0 Flash-Lite en OpenAI maakte de ChatGPT-zoekfunctie gratis beschikbaar voor alle gebruikers, zodat gebruikers de zoekfunctie kunnen gebruiken om meer uiteenlopende taken uit te voeren. Het interne Meta-team intensiveert ook het onderzoek naar strategieën voor prijsverlaging van grote modellen en promoot tegelijkertijd de verdere ontwikkeling van Meta's open source grote modellen.

In dit zeer competitieve veld kan geen enkel bedrijf comfortabel op de eerste plaats zitten. Bedrijven proberen gebruikers aan te trekken en te behouden door de kosteneffectiviteit te verbeteren. Deze trend zal grote modellen helpen om van pure technologische ontwikkeling naar bredere toepassing te gaan, en de toekomstige markt voor grote modellen zal blijven evolueren en veranderen in de concurrentie om kosteneffectiviteit.