Wysoki koszt korzystania z dużych modeli AI jest głównym powodem, dla którego wiele aplikacji AI nie zostało jeszcze wdrożonych i promowanych. Wybór ekstremalnej wydajności oznacza ogromne koszty mocy obliczeniowej, co prowadzi do wysokich kosztów użytkowania, których zwykli użytkownicy nie mogą zaakceptować.

Konkurencja dużych modeli AI jest jak wojna bez dymu. Po tym, jak DeepSeek wydał i udostępnił kod źródłowy najnowszego dużego modelu R1, OpenAI również wydało swój własny najnowszy model o3 pod presją. Gracz dużych modeli Google również musiał dołączyć do zaciętej konkurencji o tanie modele.

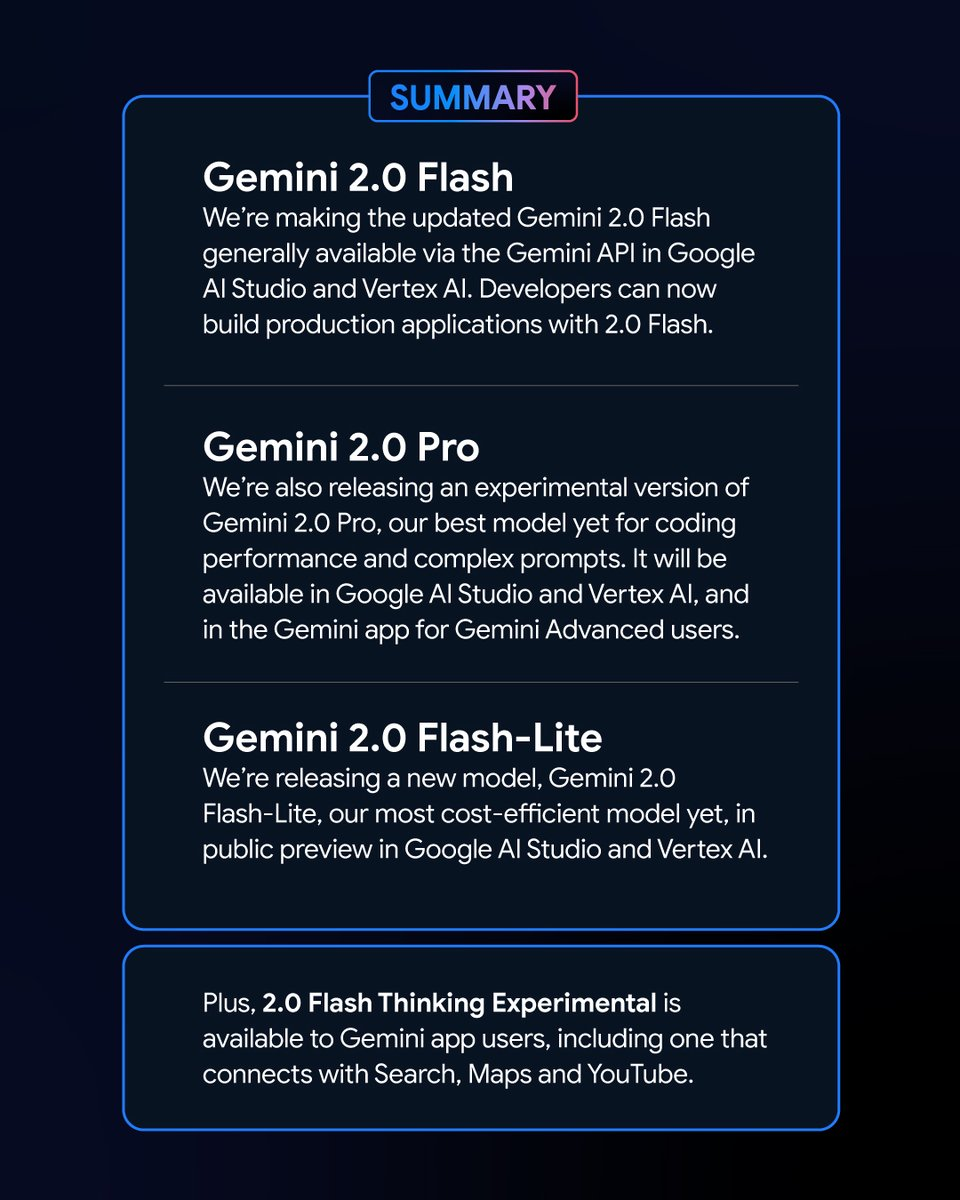

Nowy ruch Google’a: zaprezentowano nowych członków serii Gemini

Wczesnym rankiem 6 lutego Google uruchomiło serię nowych wersji modelu Gemini. Wśród nich znalazła się wersja eksperymentalna Bliźnięta 2.0 Pro i wersja zapoznawcza Gemini 2.0 Flash – Lite wzbudziły duże zainteresowanie, a najnowsza wersja Gemini 2.0 Flash została oficjalnie wydana.

Jako nowy wariant, Google Gemini 2.0 Flash – Lite ma bardzo atrakcyjną cenę wynoszącą zaledwie 0,3 USD za milion tokenów, co czyni go jak dotąd najbardziej przystępnym cenowo modelem Google.

Z drugiej strony eksperymentalna wersja Gemini 2.0 Pro dysponuje potężnymi, natywnymi możliwościami multimodalnymi, które umożliwiają konwersję tekstu, dźwięku i obrazu.

Eksperymentalna wersja Gemini 2.0 Flash Thinking jest bezpłatna i umożliwia dostęp, wyodrębnianie i podsumowywanie treści filmów z serwisu YouTube.

Logan Kilpatrick, szef produktów Google AI Studio, ogłosił na platformie X, że te modele są „najpotężniejszymi modelami w historii Google” i są dostępne dla wszystkich programistów.

Imponująca wydajność i wyniki nowych modeli Gemini w rankingu

W tabeli wyników Chatbot Arena Large Model Leaderboard Gemini 2.0 Flash Thinking Experimental Edition i Gemini 2.0 Pro Experimental Edition osiągnęły znakomite wyniki. W porównaniu z poprzednimi dużymi modelami Google, Gemini 2.0 poczyniło duże postępy i, co nie powinno dziwić, udało im się dotrzeć na szczyt tabeli wyników, a ich łączny wynik przewyższył ChatGPT-4o i DeepSeek-R1. To ogromna poprawa.

Wynik ten opiera się na kompleksowej ocenie możliwości dużych modeli w różnych dziedzinach, obejmujących matematykę, kodowanie i przetwarzanie wielojęzyczne.

Cena i wydajność: każda wersja Gemini 2.0 ma swoje zalety

Różne wersje Gemini 2.0 mają swoje własne cechy pod względem ceny i wydajności. Osiągnięto równowagę między wydajnością a ceną, dając użytkownikom większy wybór. Interfejsy API różnych wersji Gemini 2.0 można wywołać za pośrednictwem Google AI Studio i Vertex AI. Deweloperzy i użytkownicy mogą wybrać odpowiednią wersję zgodnie ze swoimi potrzebami.

Gemini 2.0 poczyniło duże postępy i rozwój w porównaniu do Gemini 1.5. Chociaż różne wersje Gemini 2.0 różnią się, wszystkie zostały ogólnie ulepszone. W szczególności musisz określić scenariusz, którego używasz, a następnie możesz lepiej wybrać model Gemini, który Ci odpowiada.

Jeśli chodzi o cenę, Gemini 2.0 Flash i Gemini 2.0 Flash – Lite skupiają się na lekkiej implementacji. Obsługują do 1 miliona tokenów w długości okna kontekstowego, a jeśli chodzi o cenę, rozróżnienie między przetwarzaniem długiego i krótkiego tekstu w Gemini 1.5 Flash zostało usunięte, a cena jest ujednolicona jako cena jednostkowa tokena.

Koszt Gemini 2.0 Flash wynosi 0,4 USD za milion tokenów za dane wyjściowe tekstu, co stanowi połowę ceny Gemini 1.5 Flash przy przetwarzaniu długich tekstów.

Gemini 2.0 Flash – Lite jest jeszcze lepszy w optymalizacji kosztów w scenariuszach wyjścia tekstu na dużą skalę, z ceną wyjścia tekstu wynoszącą 0,3 USD za milion tokenów. Nawet dyrektor generalny Google, Sundar Pichai, chwalił go jako „wydajny i wydajny”.

Pod względem poprawy wydajności Gemini 2.0 Flash ma bardziej kompleksowe funkcje interakcji multimodalnej niż wersja Lite. Ma obsługiwać wyjście obrazu, a także dwukierunkowe wejście i wyjście w czasie rzeczywistym o niskim opóźnieniu dla modalności, takich jak tekst, dźwięk i wideo.

Eksperymentalna wersja Gemini 2.0 Pro wyróżnia się pod względem wydajności kodowania i złożonych monitów. Jej okno kontekstowe może osiągnąć do 2 milionów tokenów, a jej ogólna zdolność wzrosła z 75.8% do 79.1% w porównaniu z poprzednią generacją, co stanowi znaczącą różnicę w zdolności kodowania i rozumowania z Gemini 2.0 Flash i Gemini 2.0 Flash – Lite.

Zespół tworzący aplikację Gemini poinformował na platformie X, że użytkownicy Gemini Advanced mogą uzyskać dostęp do eksperymentalnej wersji Gemini 2.0 Pro za pośrednictwem menu rozwijanego modelu, a eksperymentalna wersja Gemini 2.0 Flash Thinking jest bezpłatna dla użytkowników aplikacji Gemini i może być używana w połączeniu z serwisem YouTube, wyszukiwarką Google i Mapami Google.

Przeciwdziałanie konkurencji: konkurs na opłacalność modelu Google

W czasach, gdy koszt rozwoju modelu stał się gorącym tematem w branży, wprowadzenie na rynek modelu DeepSeek – R1 o otwartym kodzie źródłowym, niedrogiego i wydajnego, miało wpływ na całą branżę.

Podczas telekonferencji po publikacji raportu finansowego Google za czwarty kwartał 2024 r. Pichai, doceniając osiągnięcia DeepSeek, podkreślił również, że seria modeli Gemini przoduje pod względem równowagi między kosztami, wydajnością i opóźnieniem, a ich ogólna wydajność jest lepsza niż modeli DeepSeek V3 i R1.

Z perspektywy rankingu testu wydajności dużych modeli LiveBench stworzonego przez Yanga Likuna i jego zespół, ogólna ocena Gemini 2.0 Flash jest wyższa niż DeepSeek V3 i OpenAI o1 – mini, ale jest za DeepSeek – R1 i OpenAI o1. Jednak wprowadzenie przez Google Gemini 2.0 Flash – Lite jest jak karta przetargowa. Google ma nadzieję, że najnowsze duże modele będą dostępne cenowo dla większej liczby osób, obniży koszty użytkowania użytkowników i zajmie miejsce w konkurencji między firmami pod względem ceny/wydajności.

Po tym jak Google wydało najnowszy Gemini 2.0, pewien internauta zaczął próbować samodzielnie analizować Gemini 2.0 Flash i inne popularne modele deepseek i openai GPT-4o. Odkrył, że nowa wersja Gemini 2.0 Flash przewyższa dwa pozostałe modele pod względem wydajności i kosztów. Daje nam to również wgląd w rozwój i ewolucję Google, a to dobry początek.

Dokładniej, Gemini 2.0 Flash kosztuje 0,1 USD za milion tokenów za wejście i 0,4 USD za wyjście, co jest znacznie mniej niż DeepSeek V3. To ogromna poprawa i rozwój. Internauta zauważył również na platformie X: „Oficjalna wersja Gemini 2.0 Flash kosztuje jedną trzecią GPT-4o-mini, podczas gdy jest trzy razy szybsza”.

Nowy trend na rynku dużych modeli: najważniejszy jest stosunek jakości do ceny

Obecnie rynek dużych modeli jest uwikłany w nową wojnę cenową. W przeszłości wysoki koszt korzystania z dużych modeli wywoływał pewien opór wobec ich używania i promocji. Wpływ wojny cenowej na duże modele wywołanej przez DeepSeek na zagraniczny rynek dużych modeli nadal fermentuje. Jednocześnie opcja open source pozwoliła większej liczbie użytkowników zrozumieć i wykorzystać najnowsze wyniki badań dużych modeli. Strategia open source + niska cena wywarła również presję na wiele amerykańskich firm zajmujących się dużymi modelami.

Google uruchomiło Gemini 2.0 Flash-Lite, a OpenAI udostępniło funkcję wyszukiwania ChatGPT bezpłatnie wszystkim użytkownikom, dzięki czemu użytkownicy mogą używać funkcji wyszukiwania do wykonywania bardziej zróżnicowanych zadań. Wewnętrzny zespół Meta również intensyfikuje badania nad strategiami redukcji cen dużych modeli, jednocześnie promując dalszy rozwój dużych modeli open source Meta.

W tej wysoce konkurencyjnej dziedzinie żadna firma nie może wygodnie zająć pierwszego miejsca. Firmy starają się przyciągać i zatrzymywać użytkowników, poprawiając opłacalność. Ten trend pomoże dużym modelom przejść od czystego rozwoju technologii do szerszego zastosowania, a przyszły rynek dużych modeli będzie nadal ewoluował i zmieniał się w konkurencji o opłacalność.