Den höga kostnaden för att använda stora AI-modeller är en viktig anledning till att många AI-applikationer ännu inte har implementerats och marknadsförts. Att välja extrem prestanda innebär enorma kostnader för datorkraft, vilket leder till höga användningskostnader som vanliga användare inte kan acceptera.

Konkurrensen om stora AI-modeller är som ett krig utan rök. Efter att DeepSeek släppt och öppnat källkod den senaste R1 stora modellen, släppte OpenAI också sin egen senaste o3-modell under press. Den stora modellaktören Google fick också ansluta sig till den hårda konkurrensen om lågprismodeller.

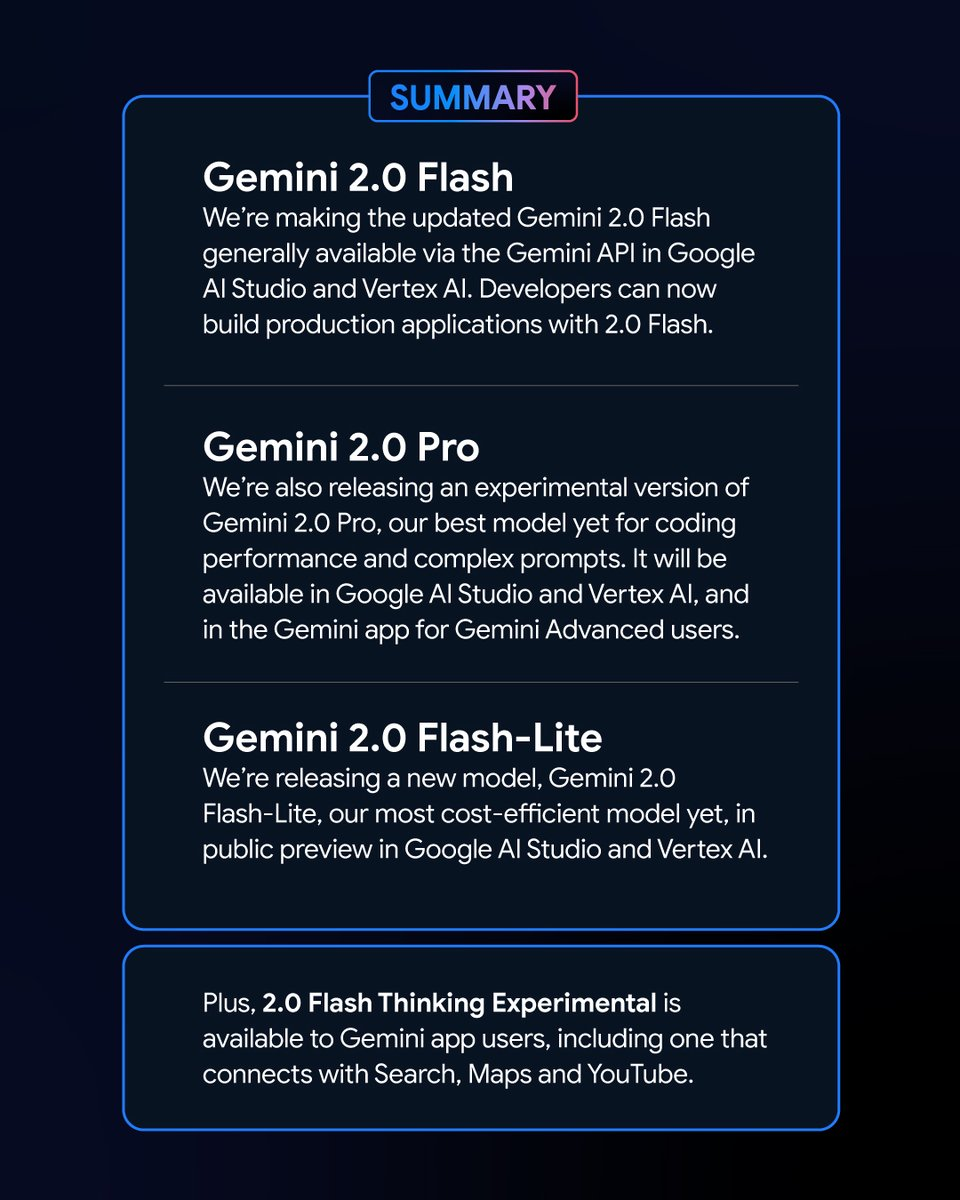

Googles nya drag: nya medlemmar i Gemini-serien presenteras

Tidigt på morgonen den 6 februari lanserade Google en serie nya versioner av Gemini-modellen. Bland dem den experimentella versionen av Gemini 2.0 Pro och förhandsversionen av Gemini 2.0 Flash – Lite väckte stor uppmärksamhet, och den senaste versionen av Gemini 2.0 Flash släpptes officiellt.

Som en ny variant, Google Gemini 2.0 Flash – Lite har ett mycket attraktivt pris på endast 0,3 USD per miljon tokens, vilket gör den till Googles mest prisvärda modell hittills.

Den experimentella versionen av Gemini 2.0 Pro, å andra sidan, har kraftfulla inbyggda multimodala möjligheter som kan konvertera mellan text och ljud och video.

Den experimentella versionen av Gemini 2.0 Flash Thinking är gratis att använda och har även möjlighet att komma åt, extrahera och sammanfatta innehållet i YouTube-videor.

Logan Kilpatrick, chef för Google AI Studio-produkter, meddelade på X-plattformen att dessa modeller är "de mest kraftfulla modellerna i Googles historia" och är tillgängliga för alla utvecklare.

De nya Gemini-modellernas imponerande prestanda och resultat på topplistan

I Chatbot Arena Large Model Leaderboard har Gemini 2.0 Flash Thinking Experimental Edition och Gemini 2.0 Pro Experimental Edition uppnått enastående resultat. Jämfört med tidigare stora Google-modeller har Gemini 2.0 gjort stora framsteg, och föga överraskande har de framgångsrikt nått toppen av topplistan, med en sammanlagd poäng som överträffar ChatGPT-4o och DeepSeek-R1. Detta är en enorm förbättring.

Detta resultat är baserat på en omfattande utvärdering av förmågan hos stora modeller inom olika områden, inklusive matematik, kodning och flerspråkig bearbetning.

Pris och prestanda: varje variant av Gemini 2.0 har sina egna fördelar

De olika versionerna av Gemini 2.0 har sina egna egenskaper vad gäller pris och prestanda. En balans mellan prestanda och pris har uppnåtts, vilket ger användarna fler valmöjligheter. API:erna för de olika versionerna av Gemini 2.0 kan anropas via Google AI Studio och Vertex AI. Utvecklare och användare kan välja lämplig version efter deras behov.

Gemini 2.0 har gjort stora framsteg och utveckling jämfört med Gemini 1.5. Även om de olika versionerna av Gemini 2.0 har skillnader har de alla förbättrats överlag. Specifikt måste du bestämma scenariot du använder, och sedan kan du bättre välja den Gemini-modell som passar dig.

Prismässigt fokuserar Gemini 2.0 Flash och Gemini 2.0 Flash – Lite på lätta utbyggnader. De stöder upp till 1 miljon tokens i längden på sammanhangsfönstret, och när det gäller prissättning har skillnaden mellan lång och kort textbehandling i Gemini 1.5 Flash tagits bort, och priset är enhetligt till ett enhetstokenpris.

Gemini 2.0 Flash kostar 0,4 USD per miljon tokens för textutmatning, vilket är halva priset på Gemini 1.5 Flash vid bearbetning av långa texter.

Gemini 2.0 Flash – Lite är ännu bättre på kostnadsoptimering i storskaliga textutdatascenarier, med en textutmatningspris på 0,3 USD per miljon tokens. Till och med Googles vd Sundar Pichai berömde det som "effektivt och kraftfullt".

När det gäller prestandaförbättring har Gemini 2.0 Flash mer omfattande multimodala interaktionsfunktioner än Lite-versionen. Den är planerad att stödja bildutmatning, såväl som dubbelriktad realtidsinmatning och utmatning med låg latens av modaliteter som text, ljud och video.

Den experimentella versionen av Gemini 2.0 Pro utmärker sig när det gäller kodningsprestanda och komplexa uppmaningar. Dess kontextfönster kan nå upp till 2 miljoner tokens, och dess allmänna förmåga har ökat från 75.8% till 79.1% jämfört med föregående generation, vilket är en betydande skillnad i kodnings- och resonemangsförmåga med Gemini 2.0 Flash och Gemini 2.0 Flash – Lite.

Gemini-applikationsteamet sa på X-plattformen att Gemini Advanced-användare kan komma åt Gemini 2.0 Pro-experimentversionen via rullgardinsmenyn för modell, och Gemini 2.0 Flash Thinking-experimentversionen är gratis för Gemini-applikationsanvändare, och den här versionen kan användas tillsammans med YouTube, Google-sökning och Google Maps.

Motverka konkurrens: Googles modellkostnadseffektivitetstävling

I en tid då kostnaden för modellutveckling har blivit ett hett ämne i branschen, har lanseringen av den låga kostnaden och högpresterande DeepSeek – R1 med öppen källkod haft en inverkan på hela branschen.

Under telefonkonferensen efter utgivningen av Googles finansiella rapport för fjärde kvartalet 2024, betonade Pichai, samtidigt som han erkände prestationerna med DeepSeek, också att Gemini-serien av modeller är ledande i balansen mellan kostnad, prestanda och latens, och att deras totala prestanda är bättre än DeepSeek:s V3- och R1-modeller.

Ur perspektivet av rankningen av LiveBenchs benchmarktest för stormodeller som byggts av Yang Likun och hans team, är den totala rankningen för Gemini 2.0 Flash högre än den för DeepSeek V3 och OpenAI:s o1 – mini, men den ligger bakom DeepSeek – R1 och OpenAI:s o1. Googles lansering av Gemini 2.0 Flash – Lite är dock som ett trumfkort. Google hoppas kunna göra de senaste stora modellerna överkomliga för fler, minska användarnas användningskostnader och hoppas kunna ta en plats i konkurrensen mellan företag om pris/prestanda.

Efter att Google släppte senaste Gemini 2.0, började en nätanvändare försöka analysera Gemini 2.0 Flash och andra populära deepseek och openai GPT-4o-modeller på egen hand. Han fann att den nya versionen av Gemini 2.0 Flash överträffar de två andra modellerna både vad gäller prestanda och kostnad. Detta ger oss också en glimt av Googles utveckling och evolution, och det är en bra början.

Specifikt kostar Gemini 2.0 Flash 0,1 USD per miljon tokens för input och 0,4 USD för utdata, som båda är mycket lägre än DeepSeek V3. Detta är en enorm förbättring och utveckling. Nätbrukaren påpekade också på X-plattformen: "Den officiella versionen av Gemini 2.0 Flash kostar en tredjedel av GPT-4o-mini, medan den är tre gånger så snabb."

En ny trend på den stora modellmarknaden: valuta för pengarna är kung

Idag är det stora modellfältet fångat i ett nytt priskrig. Tidigare har de höga kostnaderna för att använda stora modeller skapat ett visst motstånd mot deras användning och marknadsföring. Effekten av priskriget för stora modeller som utlösts av DeepSeek på den utomeuropeiska marknaden för stora modeller fortsätter att jäsa. Samtidigt har alternativet med öppen källkod också gjort det möjligt för fler användare att förstå och använda de senaste forskningsresultaten för stora modeller. Strategin med öppen källkod + lågpris har också satt press på många amerikanska stora modellföretag.

Google lanserade Gemini 2.0 Flash-Lite, och OpenAI gjorde ChatGPT-sökfunktionen fritt tillgänglig för alla användare, så att användare kan använda sökfunktionen för att utföra fler olika uppgifter. Metas interna team intensifierar också forskningen om prissänkningsstrategier för stora modeller samtidigt som de främjar vidareutvecklingen av Metas stora modeller med öppen källkod.

Inom detta mycket konkurrensutsatta område kan inget företag sitta bekvämt på första plats. Företag försöker attrahera och behålla användare genom att förbättra kostnadseffektiviteten. Denna trend kommer att hjälpa stora modeller att gå från ren teknikutveckling till bredare tillämpning, och den framtida marknaden för stora modeller kommer att fortsätta att utvecklas och förändras i konkurrensen om kostnadseffektivitet.